الگوریتمهای مخفی

که پول و اطلاعات را کنترل میکنند. فرانک

پاسکواله

The Black Box Society:

The Secret Algorithms That

Control Money and Information . (Frank Pasquale)

ارائه دهند: سهیل سلیمی (مشاور

رسانه ای آزمایشگاه پژوهشی فضای سایبر دانشگاه تهران)

مقدمه: دربارهی کتاب

The Black Box Society

کتاب جامعه جعبه سیاه: الگوریتمهای مخفی

که پول و اطلاعات را کنترل میکنند

The Black Box Society: The

Secret Algorithms That Control Money and Information نوشتهی فرانک

پاسکوال، حقوقدان و استاد دانشگاه مریلند، کتابی تأثیرگذار

در زمینهی شفافیت، نظارت و قدرت در عصر دیجیتال است.

این کتاب به بررسی سازوکارهای مخفی در پس الگوریتمهایی میپردازد

که بر اقتصاد، رسانه، و زندگی اجتماعی ما سلطه یافتهاند. او

مفهوم "جامعه جعبهسیاه" را بهکار میبرد تا

توصیف کند که چگونه شرکتهای فناوری، مؤسسات

مالی و دولتها تصمیماتی میگیرند که

ما نمیتوانیم آنها را ببینیم، درک کنیم یا به چالش

بکشیم.

پاسکوال استدلال میکند که در حالی که

رفتار شهروندان عادی هر روز شفافتر میشود و تحت

نظارت است، ساختارهای قدرتی که بر اطلاعات و سرمایه کنترل دارند، روزبهروز مبهمتر و غیرپاسخگوتر میشوند. این

کتاب خواستار شفافسازی الگوریتمها، بازتعریف

حقوق حریم خصوصی، و نظارت دموکراتیک بر فناوری است.

جامعه جعبه سیاه، جامعهای با شهروندان

تحت نظارت و شرکتهای غیرپاسخگوست.

The black box society is one of

monitored citizens and unaccountable corporations.

تحلیل کتاب جامعه جعبه سیاه:

الگوریتمهای پنهانی که پول

و اطلاعات را کنترل میکنند اثر

فرانک پاسکواله (Frank Pasquale)

مقدمه:

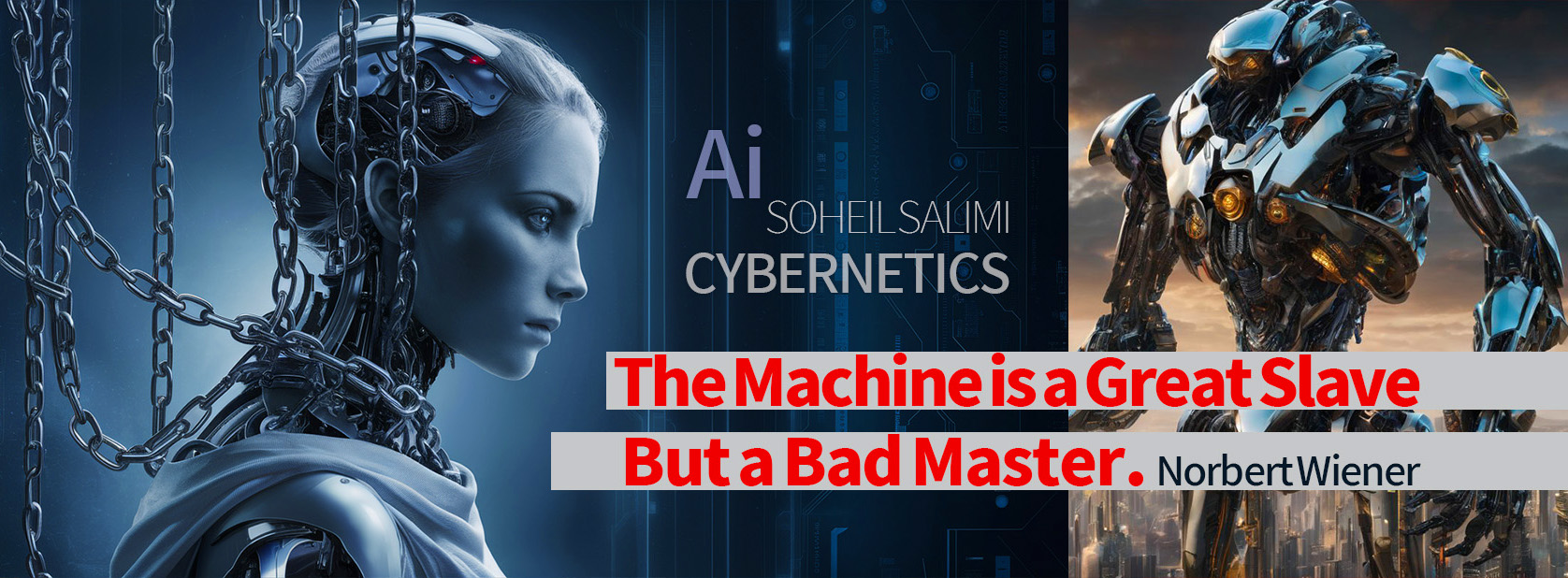

در عصر دیجیتال، الگوریتمها و هوش

مصنوعی نه تنها ابزارهایی فنی، بلکه سازههای قدرت جدیدی

هستند که سرنوشت افراد، بازارها و جوامع را به شکلی بیسابقه و

غالباً پنهانی رقم میزنند. کتاب

"جامعه جعبه سیاه" اثر فرانک پاسکواله، نقدی

بنیادین به این وضعیت ارائه میدهد. پاسکواله

استدلال میکند که ما در حال ساخت

یک "جامعه جعبه سیاه" هستیم: جامعهای که در

آن تصمیمات حیاتی توسط سیستمهای الگوریتمی

پیچیده (جعبههای سیاه) اتخاذ میشوند که

درک، بررسی یا به چالش کشیدن آنها برای عموم مردم، نهادهای نظارتی و حتی متخصصان غیرمرتبط غیرممکن یا

بسیار دشوار است. این عدم شفافیت در دو حوزه حیاتی به اوج میرسد: امور مالی که پول

و اعتبار ما را کنترل میکند و اطلاعات که درک

ما از جهان را شکل میدهد.

محورهای انتقادی پاسکواله:

1.

انحصار داده و

قدرت: غولهای فناوری

(مانند گوگل، فیسبوک/متا، آمازون) و مؤسسات مالی بزرگ، انبوه بیسابقهای از دادههای شخصی

و رفتاری را در انحصار خود دارند. الگوریتمهای آنها

بر اساس این دادهها تصمیم

میگیرند، اما منطق این

تصمیمگیریها محرمانه است.

2.

تبعیض الگوریتمی: الگوریتمها میتوانند

و اغلب تبعیض سیستماتیک را

علیه گروههای خاص (بر اساس نژاد،

جنسیت، طبقه اجتماعی، کدپستی و ...) بازتولید و حتی تشدید میکنند، بدون

اینکه مسئولیت آن بر عهده کسی باشد یا امکان اعتراض مؤثر وجود داشته باشد.

3.

تخریب حریم خصوصی

و خودمختاری: نظارت

گسترده و دائمی توسط این سیستمها، حریم

خصوصی را تحلیل برده و توانایی افراد برای شکلدهی آزادانه

به هویت و زندگی خود (خودمختاری) را تهدید میکند.

4.

عدم پاسخگویی و

مسئولیتپذیری: هنگامی که یک

الگوریتم اشتباه میکند (مثلاً

اعتبار فردی را به اشتباه تخریب میکند، شغل

وی را حذف میکند، یا او را به اشتباه

مجرم جلوه میدهد)، شناسایی مقصر،

درخواست توضیح یا جبران خسارت بسیار دشوار است. سازندگان الگوریتم به اسرار

تجاری و پیچیدگی فنی استناد میکنند.

5.

تهدید دموکراسی: قدرت متمرکز و

غیرپاسخگو در دستان صاحبان این جعبههای سیاه، تعادل

دموکراتیک را به هم میزند. این

شرکتها میتوانند افکار عمومی

را شکل دهند، انتخابات را تحت تأثیر قرار دهند و سیاستگذاران

را تنظیمگری کنند، بدون اینکه

در معرض نظارت و کنترل کافی باشند.

موضع کتاب: پاسکواله

به شدت هشداردهنده و مصلحانه است.

او نه ضد فناوری، بلکه خواهان شفافیت، نظارت و

مسئولیتپذیری در

طراحی و استقرار سیستمهای الگوریتمی

است. او استدلال میکند که

برای حفظ عدالت، برابری و دموکراسی در عصر دیجیتال، باید قوانین و نهادهای جدیدی ایجاد

کنیم تا این جعبههای سیاه

را باز کنیم و آنها را در برابر جامعه پاسخگو نگه داریم.

خلاصه و تحلیل فصلهای کتاب The Black Box Society (Pasquale):

- فصل 1: Reputation in Ruins اعتبار

در ویرانهها

- خلاصه: این

فصل بر سیستمهای

اعتبارسنجی مانند FICO و شرکتهای

دادهای (مانند اکسیوم،

لکسنکس) تمرکز دارد.

پاسکواله نشان میدهد

چگونه این شرکتها انبوهی از دادهها

(اغلب نادرست یا نامرتبط) را درباره افراد جمعآوری

میکنند تا

"نمرات" و "پروفایلهای"

مخفیانه ایجاد کنند که بر دسترسی به وام، مسکن، شغل و حتی خدمات بیمهای

تأثیر میگذارند.

منطق این سیستمها

برای افراد تحت تأثیر غیرقابل فهم و قابل اعتراض است.

- تحلیل فصل: پاسکواله

پایههای "جعبه

سیاه" را در قلب اقتصاد مالی نشان میدهد.

این فصل به وضوح عدم

تقارن اطلاعاتی فاجعهباری

را آشکار میسازد

که در آن شرکتهای

خصوصی بر زندگی افراد قدرت مطلق دارند، بدون هیچ شفافیت یا مسئولیتپذیری.

این سیستمها تبعیض

ساختاری را نهادینه

میکنند و فرصتهای

اقتصادی را بر اساس معیارهای پنهان محدود میسازند.

- فصل 2: The Hidden Logics of Search منطق

پنهان جستجو

- خلاصه: پاسکواله

به دنیای موتورهای جستجو (بهویژه

گوگل) و رسانههای

اجتماعی میپردازد.

او توضیح میدهد

که الگوریتمهای

رتبهبندی و فیلترینگ

چگونه بهشکلی

پنهانی اطلاعاتی را که کاربران میبینند،

انتخاب و اولویتبندی

میکنند. این

"منطق پنهان" میتواند

دیدگاهها را شکل دهد،

افکار عمومی را هدایت کند، کسبوکارها

را موفق یا شکستخورده

نشان دهد و حتی بر نتایج انتخابات تأثیر بگذارد. انگیزههای

تجاری و سوگیریهای

طراحان در این الگوریتمها

نهفته است.

- تحلیل فصل: این

فصل قدرت عظیم کنترل

اطلاعات توسط غولهای

فناوری را برجسته میکند.

پاسکواله نشان میدهد

که چگونه جعبه سیاه جستجو و فیلتر، نه تنها یک نگرانی حریم خصوصی، بلکه یک تهدید

اساسی برای ادراک عمومی، گفتمان دموکراتیک و رقابت اقتصادی است.

تمرکز بر گوگل بهعنوان

مطالعه موردی، قدرت نامتقارن و عدم شفافیت این بازیگران را بهطور

ملموس نشان میدهد.

- فصل 3: Finance's Algorithms الگوریتمهای

مالی

- خلاصه: این

فصل به عمق "جعبه سیاه" وال استریت میرود.

پاسکواله الگوریتمهای

معاملات فرکانس بالا (HFT)، سیستمهای

امتیازدهی اعتباری پیچیده برای اوراق بهادار، و پلتفرمهای

معاملاتی تاریک را بررسی میکند.

او نشان میدهد

که چگونه این فناوریها

نهتنها برای دستکاری

بازار و کسب سود غیرمنصفانه استفاده میشوند،

بلکه ثبات سیستم مالی را تهدید میکنند

(مانند سقوط فلش 2010). نظارت تنظیمگران

بر این سیستمهای

فوقپیچیده و محرمانه

ناکافی است.

- تحلیل فصل: پاسکواله

پیوند خطرناک بین فناوریهای

غیرشفاف و بیثباتی

سیستمیک را آشکار میسازد.

این فصل نشان میدهد

که چگونه الگوریتمهای

مالی به ابزاری برای انحصارطلبی

اطلاعاتی، استخراج رانت و دور زدن مقررات تبدیل

شدهاند و چگونه

فقدان شفافیت، توانایی جلوگیری از بحرانهای

بعدی را تضعیف میکند.

قدرت شرکتهای

مالی در پنهانکاری

با بهانه "اسرار تجاری" به چالش کشیده میشود.

- فصل 4: The Automated Public Sphere عرصه

عمومی خودکار

- خلاصه: پاسکواله گسترش جعبه سیاه را

به حوزههای عمومی مانند

نظارت پلیس (پیشبینی

جرم، تشخیص چهره)، عدالت کیفری (الگوریتمهای

ارزیابی خطر، احکام مجازات) و خدمات دولتی (تعیین واجدین شرایط برای کمکها)

ردیابی میکند.

او نگرانیهای عمیقی

در مورد تقویت تبعیض بهویژه علیه

اقلیتها، تخریب

فرآیندهای دادرسی منصفانه و واگذاری

تصمیمگیریهای حیاتی

انسانی به ماشینهای غیرقابل

توضیح مطرح میکند.

- تحلیل فصل: این

فصل هشداردهندهترین

پیامدهای جامعه جعبه سیاه را نشان میدهد: نهادینهسازی

بیعدالتی در قلب

دولت و سیستم قضایی. پاسکواله

استدلال میکند

که اتوماسیون، در غیاب شفافیت و مسئولیتپذیری،

به جای خنثیسازی، سوگیریهای

انسانی و ساختاری موجود را تشدید و توجیه میکند،

حقوق شهروندی را تضعیف و اعتماد به نهادهای عمومی را از بین میبرد.

- فصل 5: Toward an Intelligible Society به

سوی جامعهای

قابل فهم

- خلاصه: در

فصل پایانی، پاسکواله مجموعهای

از پیشنهادات

اصلاحی را برای باز

کردن جعبههای

سیاه و ایجاد پاسخگویی ارائه میدهد.

اینها شامل الزامات شفافیت

هدفمند (توضیحپذیری

الگوریتمها

برای افراد تحت تأثیر و نهادهای نظارتی)، تقویت قوانین

حفاظت از دادهها،

ایجاد نهادهای

نظارتی جدید با

تخصص فنی، به رسمیت شناختن حق

انسانها برای تصمیمگیری

نهایی در موارد

مهم (مانند استخدام، وام، عدالت کیفری)، و احیای قدرت

چانهزنی جمعی در

برابر انحصار دادهها

است.

- تحلیل فصل: این

فصل فراخوانی عملگرایانه

و فوری برای اقدام

است. پاسکواله بهجای

رد فناوری، بر طراحی

مجدد سیستمها

و قوانین برای

اطمینان از همسویی آنها با ارزشهای

دموکراتیک مانند عدالت، برابری و پاسخگویی تأکید میکند.

او استدلال میکند

که دستیابی به یک "جامعه

قابل فهم" نه

تنها ممکن، بلکه برای بقای مردم سالاری، البته اگر وجود داشته باشد! ضروری

است. پیشنهادات او چارچوبی حیاتی برای سیاستگذاری

آینده ارائه میدهد.

جملات کلیدی کتاب The Black Box Society (Pasquale)

1.

ما در حال ساختن

یک جامعه جعبه سیاه هستیم.

We are building a black

box society.

2.

جعبه سیاهها در امور

مالی و اطلاعات، قدرت را متمرکز و پاسخگویی را تضعیف میکنند.

Black boxes in finance and

information concentrate power and undermine accountability.

3.

الگوریتمها، ناظران

قدرتمند و غیرقابل نظارتی هستند.

Algorithms are powerful,

unaccountable scrutineers

4.

نمرات اعتباری

مخفی، فرصتهای زندگی را تعیین

میکنند.

Secret credit scores determine

life chances.

5.

منطقِ جستجو پنهان

است و دید ما به جهان را شکل میدهد.

The logic of search is hidden

and shapes our view of the world.

6.

گوگل یک قدرت

فیلترینگ جهانی است.

Google is a global filtering

power.

7. الگوریتمهای مالی

میتوانند بازارها را

تخریب کنند.

Finance algorithms can

wreck markets.

8.

معاملات فرکانس بالا، یک مزیت اطلاعاتی

ناعادلانه ایجاد میکند.

High-frequency trading creates an unfair

information advantage.

9.

پیشبینی جرم،

تبعیض را نهادینه میکند.

Predictive policing

institutionalizes discrimination.

10.

الگوریتمهای ارزیابی

ریسک در عدالت کیفری، تعصبات را تقویت میکنند.

Risk assessment algorithms in

criminal justice reinforce biases.

11.

اسرار تجاری به

سپری برای پنهانکاری تبدیل

شدهاند.

Trade secrets have become a

shield for opacity.

12.

پیچیدگی فنی نباید

بهانهای برای عدم پاسخگویی

باشد.

Technical complexity should not

be an excuse for unaccountability.

13.

ما به حق توضیح

نیاز داریم.

We need a right to explanation.

14.

دادهها منابع جدید قدرت هستند.

Data is a new source of power.

15.

انحصار داده،

تهدیدی برای دموکراسی است.

Data monopoly is a threat to

democracy.

16.

الگوریتمها میتوانند

اشتباه کنند و آسیبهای واقعی

ایجاد کنند.

Algorithms can make mistakes and

cause real harm.

17.

شفافیتِ هدفمند

ضروری است.

Targeted transparency is

essential.

18.

نهادهای نظارتی

جدید با تخصص فنی مورد نیاز است.

New regulatory bodies with

technical expertise are needed.

19.

انسانها باید

در تصمیمگیریهای مهم

حرف آخر را بزنند.

Humans must have the final say

in significant decisions.

20.

قدرت چانهزنی جمعی

در برابر غولهای داده باید احیا

شود.

Collective bargaining power

against data giants must be revived.

21.

ما اغلب قربانیان

امتیازدهی مخفی هستیم. Fa:

We are often victims of secret

scoring.

22.

نتایج جستجو به

شکلی پنهانی دستکاری میشوند.

Search results are covertly

manipulated.

23.

فیلترهای شخصیسازی شده

میتوانند حبابهای فکری

ایجاد کنند.

Personalized filters can create

echo chambers.

24.

وال استریت توسط

الگوریتمها اداره میشود که

کسی آنها را درک نمیکند.

Wall Street is run by algorithms

no one understands.

25.

الگوریتمهای پلیس،

محلههای فقیرنشین را هدف

میگیرند و چرخه تبعیض

را ادامه میدهند..

Police algorithms target poor

neighborhoods, perpetuating cycles of discrimination.

26.

نمرات ریسک، عدالت

را به یک محاسبه مکانیکی تقلیل میدهند.

Risk scores reduce justice to a

mechanical calculation.

27.

سیستمهای امتیازدهی،

افراد را به اعداد تقلیل میدهند.

Scoring systems reduce people to

numbers.

28.

: "پیشبینی"

جرم، اغلب به معنای پیشداوری است.

"Predicting" crime

often means prejudging it.

29.

هوش مصنوعی بدون

شفافیت، هوش مصنوعی غیرمسئول است.

AI without transparency is

unaccountable AI.

30.

تصمیمات حیاتی

نباید صرفاً به ماشینها واگذار

شود.

Crucial decisions should not be

delegated solely to machines.

31.

دادههای شما،

طلای دیجیتال شرکتها است.

Your data is companies' digital

gold.

32.

نمره اعتباری شما

میتواند زندانی نامرئی

شما باشد.

Your credit score can be your

invisible prison.

33.

شخصیسازی، اغلب

به معنای پیشداوری است.

Personalization often means

prejudice.

34.

الگوریتمهای گوگل،

ویراستاران جهانی ما هستند.

Google's algorithms are our

global editors.

35.

بحران مالی 2008

یک فاجعه جعبه سیاه بود.

The 2008 financial crisis was a

black box disaster.

36.

نظارت پلیس

الگوریتمی، جوامع را نظامیتر میکند.

Algorithmic police surveillance militarizes

communities.

37.

ما در تاریکی

الگوریتمی زندگی میکنیم

We live in algorithmic darkness.

38.

تشخیص چهره، یک

ابزار نظارتی قدرتمند و مستعد سوءاستفاده است.

Facial recognition is a

powerful, abuse-prone surveillance tool.

39.

الگوریتمهای پیشبینی جرم،

اهداف انسانی را جایگزین شواهد میکنند.

Predictive policing algorithms

substitute human targets for evidence.

40.

سوگیری در دادهها به سوگیری

در نتایج منجر میشود.

Bias in data leads to bias in

outcomes.

41.

دادههای رفتاری،

سوخت موتورهای پیشبینی هستند.

Behavioral data is the fuel for

prediction engines.

42.

جامعه جعبه سیاه،

جامعهای با شهروندان تحت

نظارت و شرکتهای غیرپاسخگوست.

The black box society is one of

monitored citizens and unaccountable corporations.