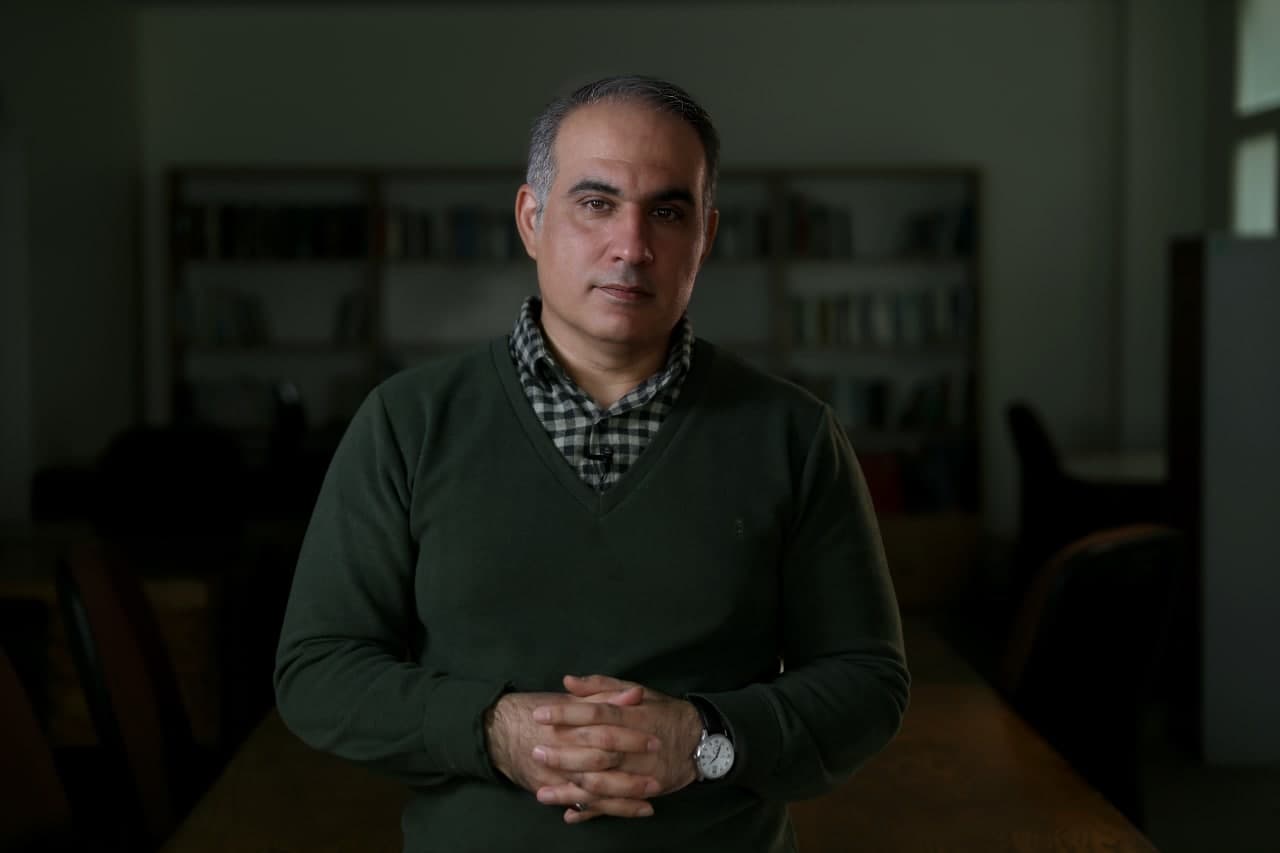

|| سهیل سلیمی SOHEIL SALIMI ||

| وبلاگ سهیل سلیمی نویسنده ، کارگردان و تهیهکننده | SOHEIL SALIMI's Weblog | Writer , Director & Producer ||| سهیل سلیمی SOHEIL SALIMI ||

| وبلاگ سهیل سلیمی نویسنده ، کارگردان و تهیهکننده | SOHEIL SALIMI's Weblog | Writer , Director & Producer |انسان ناگزیر از همزیستی با هوش مصنوعی

انسان ناگزیر از همزیستی با هوش مصنوعی

ارائهدهنده: سهیل سلیمی (مشاور رسانهای آزمایشگاه پژوهشی فضای سایبر دانشگاه تهران)

مقدمه

جهان در حال ورود به مرحلهای از تحولات فناورانه است که میتوان آن را نه صرفاً یک «دوران جدید»، بلکه «بازتعریف بنیادین» نقش انسان در نظامهای اجتماعی، اقتصادی، فرهنگی و حتی هستیشناسانه تلقی کرد.

هوش مصنوعی (AI) دیگر یک ابزار نیست؛ بلکه ساختاریست در حال تکامل که در حال بازنویسی منطق تصمیمگیری، اخلاق، آگاهی و حتی روابط انسانی است. درحالیکه دستیارهای مجازی چون Siri یا Grok تنها نوک کوه یخ هستند، آنچه در پسِ پرده در حال وقوع است، تغییر بنیادین در مفاهیم «کنترل»، «دانش»، و «عاملیت» است. این مقاله در پی آن است تا ضمن واکاوی علمی-انتقادی همزیستی انسان و هوش مصنوعی، روایتی چندلایه، پیچیده و انتقادی از فرصتها، تهدیدات، چالشها و ضرورتهای سیاستگذاری ارائه دهد.

بخش اول: مفهوم همزیستی انسان و هوش مصنوعی - از همکاری تا تقابل شناختی

تعریف رایج همزیستی انسان و هوش مصنوعی معمولاً نگاهی خوشبینانه به تعامل «مکمل» میان انسان و ماشین دارد. اما باید این تعریف را بازنگری کرد: آیا این تعامل واقعاً دوسویه و برابر است؟ یا شاهد نوعی استحاله تدریجی انسان به عنصری درون سامانهای گستردهتر هستیم که توسط منطق الگوریتمی اداره میشود؟ نوربرت وینر در اثر بنیادین خود، Cybernetics، ایده کنترل و بازخورد را نهفقط برای ماشین، بلکه برای فهم انسان در چارچوبی الگوریتمی مطرح کرد (Wiener, 1948).

ایزاک آسیموف، نویسنده برجسته علمی-تخیلی، در داستانهای خود مانند من، ربات (1950) قوانین سهگانه رباتیک را معرفی کرد که بهعنوان چارچوبی اخلاقی برای تعامل انسان و ماشین طراحی شدهاند:

1. یک ربات نباید به انسان آسیب برساند یا با بیعملی اجازه دهد آسیبی به انسان برسد.

2. یک ربات باید از دستورات انسانها اطاعت کند، مگر اینکه این دستورات با قانون اول مغایرت داشته باشند.

3. یک ربات باید از خود محافظت کند، به شرطی که این حفاظت با قوانین اول و دوم در تضاد نباشد (Asimov, 1950, p. 40).

این قوانین، اگرچه در داستانهای تخیلی او مطرح شدند، اما الهامبخش بحثهای امروزی درباره اخلاق در هوش مصنوعی هستند، زیرا از منظر آسیموف و بر مبنای نوشتههایش، رباتها تجلی بیرونی و فیزیکال هوش مصنوعی به شمار میروند.

ایزاک آسیموف با ارائهی قوانین سهگانه رباتیک کوشید اخلاق را در ماشین نهادینه کند، اما منتقدانی چون Joanna Bryson هشدار دادهاند که این قوانین بیشتر افسانهاند تا راهحل. زیرا در واقعیت، هیچ راهحل سادهای برای تزریق ارزشهای انسانی به الگوریتمها وجود ندارد (Bryson, 2018). همچنین ابزارهایی چون Grok، ChatGPT یا DeepSeek نهتنها تصمیمساز، بلکه در مواردی تصمیمگیر نیز شدهاند. پس آیا میتوان همچنان از مفهوم همزیستی صرف صحبت کرد، یا باید به مفهوم «تقابل شناختی» اندیشید؟

تقابل شناختی (Cognitive Confrontation) مفهومیست که فراتر از تعامل یا همزیستی انسان و ماشین، به تعارض بنیادین میان دو منطق ادراکی اشاره دارد: منطق انسانی که بر شهود، تجربهزیسته، اخلاق، و زمینههای دینی و فرهنگی استوار است، در برابر منطق ماشین که بر دادهمحوری، محاسبهپذیری و بهینهسازی ریاضی تکیه دارد. این تقابل زمانی پدیدار میشود که تصمیمگیریهای ماشینی به حوزههایی وارد میشوند که بهطور سنتی مختص قضاوت انسانی بودهاند—مانند قضاوت اخلاقی، عدالت، یا زیباییشناسی. الگوریتمها در این زمینهها نه فقط ابزار، بلکه رقیب معناشناختی انسان میشوند. در این وضعیت، انسان با موجودیتی مواجه است که نه میتوان آن را بهتمامی درک کرد، نه بهطور کامل کنترل. «تقابل شناختی» بهویژه در مواردی چون داوری خودکار، نظامهای پیشنهادگر محتوا، یا تحلیل رفتاری در پلتفرمهای آموزشی یا قضایی، بهوضوح قابل مشاهده است. این تقابل میتواند منجر به بحران اعتماد، احساس بیگانگی، و ازهمگسیختگی درک انسان از خود شود، چرا که مرجعیت شناختی در حال انتقال از انسان به ماشین است. در چنین شرایطی، سؤال اصلی دیگر صرفاً نحوهی استفاده از AI نیست، بلکه بازتعریف جایگاه انسان در نظم جدید شناختیست.

بخش دوم: فرصتهای هوش مصنوعی – پیشرفت یا استعمار دیجیتال؟

در نگاه نخست، هوش مصنوعی ابزاری بیبدیل برای پیشرفت تمدنیست:

- پزشکی دقیق: ابزارهایی چون IBM Watson یا Google DeepMind در حال انقلابی در تشخیص زودهنگام بیماریها هستند. اما این انقلاب همزمان مالکیت دادههای زیستی انسان را نیز به شرکتهای فراملیتی واگذار میکند. پرسش مهم این است: چه کسی صاحب "داده زیستی" (Bio-Data) است؟

- اقتصاد هوشمند؟ یا اقتصاد متمرکز؟ در حالی که شرکتهایی چون Amazon از AI برای بهینهسازی لجستیک بهره میبرند، کنترل کامل زنجیره تأمین جهانی توسط تعداد محدودی شرکت در حال وقوع است. (Zuboff, 2019) هوش مصنوعی در حال بازآرایی تمرکز ثروت و قدرت در مقیاسی بیسابقه است.

- آموزش شخصیسازیشده به نفع هوش مصنوعی: اگرچه ابزارهایی چون Khan Academy یادگیری را شخصیسازی میکنند، اما منطق نهفته در آنها—بهینهسازی عملکرد آموزشی بر اساس معیارهای کمّی—ممکن است به زوال تفکر انتقادی منجر شود.

- محیط زیست: پروژههایی مانند الگوریتم صرفهجویی انرژی Google DeepMind (2023) مؤثرند، اما باید از خود پرسید آیا AI راهحل واقعی بحرانهای زیستمحیطی است یا صرفاً تسکینی برای ادامهی وضع موجود؟ یا حتی بدتر سرپوشی برای بهره برداری و بهره کشی هوشمندانه تر از منابع زیست محیطی؟!

بخش سوم: تهدیدات همزیستی - استعمار الگوریتمی و بحران اخلاق

- بیکاری ساختاری: بر خلاف انقلابهای صنعتی پیشین، هوش مصنوعی نه صرفاً جایگزین نیروی کار جسمی، بلکه رقیب توان شناختی انسان است. گزارش WEF (2023) نشان میدهد تا سال 2030، نه تنها مشاغل عمومی و تکرار پذیر، بلکه حتی مشاغل تحلیلی، خلاقانه و هنری، حقوقی و پزشکی نیز در خطر جدی جایگزینی هستند.

- بازتولید تبعیض: الگوریتمها نهفقط سوگیریهای موجود را بازتولید میکنند بلکه آنها را نهادینه و تقویت نیز میکنند. کتاب: الگوریتمهای ستم Algorithms of Oppression اثر: سافیا نوبل Safiya Nobl، نشان میدهد چگونه موتورهای جستوجو تبعیض نژادی را بازتولید میکنند (Noble, 2018).

- تهدید امنیتی ترکیبی: در دنیای جدید، حمله سایبری به یک زیرساخت شهری توسط یک AI مستقل، صرفاً یک سناریوی تخیلی نیست. پروژههای نظامی مانند Project Maven نشان دادهاند که AI میتواند بهعنوان سلاح نیز عمل کند. ((Project Maven (پروژه ماون) یک ابتکار نظامی پیشرفته توسط وزارت دفاع آمریکا (پنتاگون) است که از هوش مصنوعی (AI) و یادگیری ماشینی (ML) برای تجزیه و تحلیل دادههای پهپادی و تصاویر ماهوارهای استفاده میکند. این پروژه نشان میدهد که چگونه فناوریهای هوش مصنوعی میتوانند در عملیاتهای نظامی بهکار گرفته شوند و حتی به عنوان سلاح مورد استفاده قرار بگیرند. ))

- نقض حریم خصوصی در مقیاس فراگیر: ChatGPT و سایر ابزارهای مشابه، از دادههای عظیم کاربران برای آموزش خود بهره میگیرند. این چرخه باعث خلق «الگوریتمهای خودتعلیمدیده» میشود که نظارتناپذیر و غیرقابل مهار هستند (Zuboff, 2019).

بخش چهارم: چالشها – از عدم شفافیت تا بحران مشروعیت

- اخلاق در سایهٔ پیچیدگی: پیچیدگی تصمیمگیری AI، مفهوم مسئولیت را دچار بحران کرده است. در تصادف خودروی خودران، مقصر کیست؟ طراح الگوریتم؟ استفادهکننده؟ یا الگوریتم خودمختار؟

- شکاف دیجیتال و استعمار هوش مصنوعی: پروژههای OpenAI،Google و xAI عمدتاً در غرب توسعه مییابند، اما اثرات جهانی دارند. آیا ملتهای جنوب جهانی صرفاً مصرفکننده خواهند ماند؟ یا قربانی استخراج داده و "مواد خام شناختی" (Cognitive Raw Materials) خواهند شد؟

- بحران اعتماد: با گسترش دیپ فیکها مردمی که درک دقیقی از AI ندارند و امروز به سوی آن حمله ور هستند دچار بحران باور یا بحران اعتماد به محتوا خواهند شد.

- مرگ شفافیت: الگوریتمهای یادگیری عمیق (Deep Learning) نهفقط غیرقابل فهم بلکه غیرقابل پیشبینی نیز هستند. این «جعبه سیاه» تهدیدی علیه اصل شفافیت در تصمیمگیریهای عمومیست.

بخش پنجم: راهکارهای پیشنهادی – آیا هنوز میتوان کنشگری کرد؟

- اخلاق الگوریتمی جهانی و الزامی: تدوین اصول الزامآور جهانی فراتر از توصیهنامهها. شاید قانون AI اتحادیه اروپا (AI Act, 2024) گامی مهم بود، اما کافی نیست مگر با حمایت نهادهای بینالمللی و مشارکت فعال کشورهای دیگر، چرا که قطعا در این اصول ارزش های غربی و محافظت از آنها مد نظر بوده است.

- آموزش انتقادی، نه صرفاً فنی: آموزش عمومی باید نهفقط بر مهارتهای فنی بلکه بر سواد الگوریتمی، فلسفه فناوری و قدرت دیجیتال متمرکز شود.

- دسترسی برابر به زیرساختها و دادهها: باید مدلهای باز (Open Source) و مشارکتی در AI توسعه یابد تا همه کشورها حق مشارکت در توسعه و هدایت این فناوری را داشته باشند.

- سازمان های مردم نهاد و عدم کار کرد نهادهای نظارتی جهانی: سازمان ملل و سازمان های جهانی اساسا تحت سیطره قدرت های بزرگ مادی جهان هستند، پس قوانین شان راحلی برای کشورهای مستقل نخواهد بود، باید کشورهای مستقل برای حمایت از هویت فرهنگی و دینی و ملی شان هوش مصنوعی را در قالب های مختلف مورد پایش منظم قرار دهند و از ابزارهای حقوقی و فرهنگی تا نظامی و بخش های مردمی مستقل و دینی بهره ببرند. یعنی باید تمام فعالیت های هوش مصنوعی زیر ذره بین های تمام ارکان حاکمیتی باشد. البته قوانین جامع و نظارت جامع بر روند تمام این فعالیت ها باید تحت اختیار یک سازمان قدرتمند باشد، اما این سازمان و ساختارش باید طوری باشد که دچار خودکامگی و انحصار و تمامیت خواهی تکنولوژیک نشود. این بخش کار واقعا حرکت در لبه تیغ است.

بخش ششم: نمونههای پیچیده و پارادوکسیکال همزیستی

Grok ساختهی xAI مثالی از ترکیب تحلیل داده با شهود انسانمحور است. اما در عین حال، این ابزار میتواند به الگوریتمی برای فیلتر و قالببندی تفکر عمومی تبدیل شود. این دوگانگی در بیشتر ابزارهای هوش مصنوعی مشاهده میشود: Google Translate میتواند تسهیلکننده گفتوگو باشد، اما در عین حال حامل ارزشهای زبانی و فرهنگی خاص نیز هست، و البته دیتای عظیمی که از زبانها مختلف دریافت کرده به عنوان خوراکی انبوه، از داده ها، برای توسعه الگوریتم های زبانی اش بهره گرفته است.

نتیجهگیری

هوش مصنوعی نهتنها واقعیتی فناورانه، بلکه نیرویی ایدئولوژیک و قدرتمند در بازتعریف هستی انسان است. همانگونه که ایزاک آسیموف اشاره کرده بود، کنترل و هدایت هوش مصنوعی نیازمند اخلاق، آگاهی، و نظارت است. اما اکنون زمان آن فرارسیده است که از «همزیستی منفعل» عبور کنیم و بهسمت «بازآفرینی نقش انسان» در اکوسیستم شناختی جدید حرکت کنیم. آینده به ما تعلق دارد، تنها اگر بتوانیم قواعد بازی را به نفع انسان بازنویسی کنیم.

ما ابزارهایی میسازیم و سپس آنها ما را بازتعریف میکنند. Marshall McLuhan

سهیل سلیمی

منابع:

• Asimov, I. (1950). I, Robot. Gnome Press.

• Wiener, N. (1948). Cybernetics: Or Control and Communication in the Animal and the Machine. MIT Press.

• McCarthy, J. (1956). The Dartmouth Conference Proposal. Dartmouth College.

• Musk, E. (2018). Interview with Axios on HBO.

• Minsky, M. (1986). The Society of Mind. Simon & Schuster.

• IBM. (2023). Watson Health Annual Report.

• Amazon. (2020). Facial Recognition Technology Report.

• Amazon. (2024). Logistics Optimization Report.

• OECD. (2023). Future of Work Report.

• Cybersecurity Ventures. (2022). AI in Cybercrime Report.

• Reuters. (2023). Italy’s ChatGPT Ban.

• UNESCO. (2024). AI Development in Africa Report.

• Gallup. (2023). Public Perception of AI Survey.

• MIT Technology Review. (2023). DeepFake Technology Analysis.

• European Commission. (2024). AI Act Legislation.

• Coursera. (2024). AI Education Impact Report.

• UN. (2023). AI Governance Committee Report.

- Bryson, J. (2018). The Artificial Intelligence of the Ethics of Artificial Intelligence: An Introductory Overview for Law and Regulation. SSRN.

- Noble, S. U. (2018). Algorithms of Oppression: How Search Engines Reinforce Racism. NYU Press.

- Zuboff, S. (2019). The Age of Surveillance Capitalism. PublicAffairs.

- World Economic Forum. (2023). Future of Jobs Report.

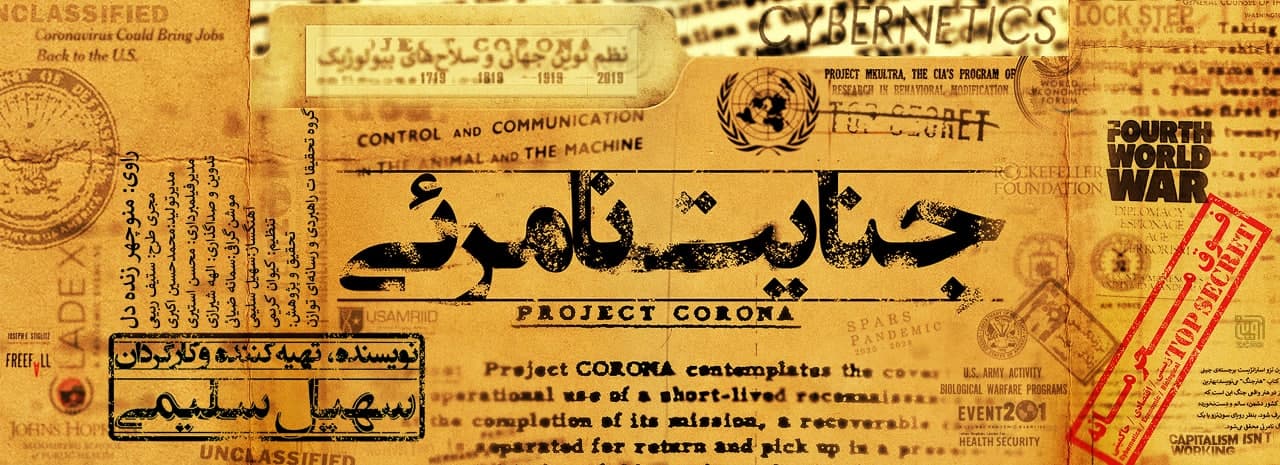

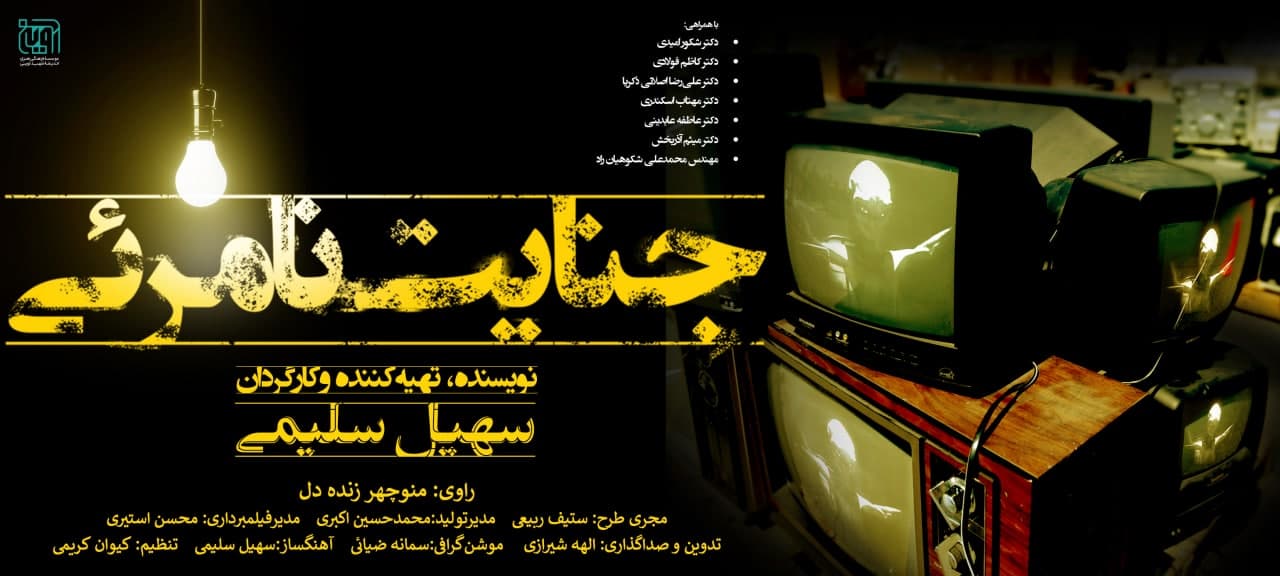

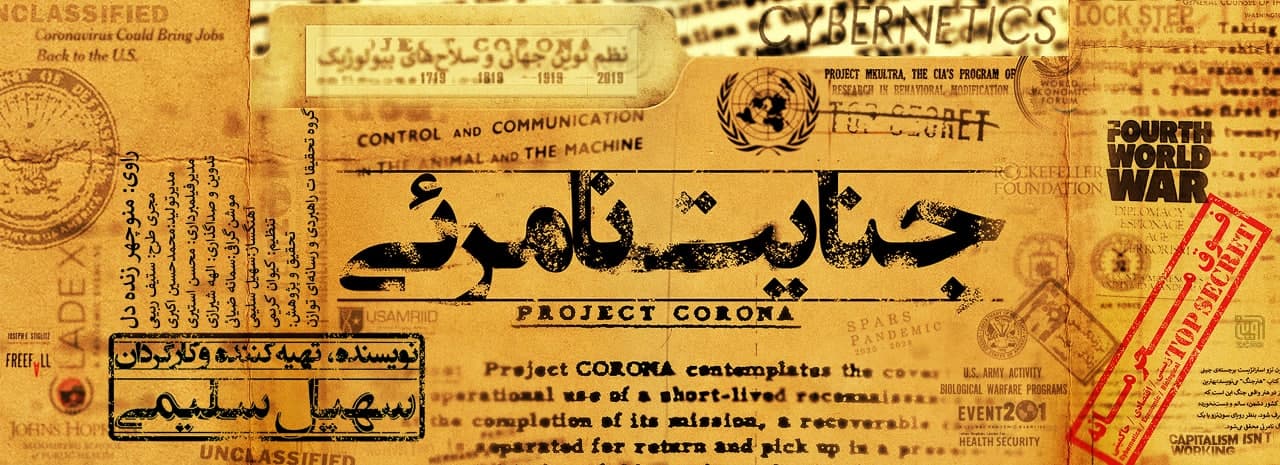

جنایت نامرئی

مستند جنایت نامرئی بزودی!!!!!!!!!

نویسنده، کارگردان و تهیه کننده: سهیل سلیمی

مستند جنایت نامرئی که به موضوع نظم نوین جهانی و ارتباطش با سلاحهای بیولوژیک و خصوصاً پاندمی کووید19 میپردازد در چهار قسمت به نویسندگی و کارگردانی سهیل سلیمی ساخته شده است. این مجموعه در راستای جهاد تبیین به بازنمایی و افشاگری گستردهای درباره صنعت بهداشت و درمان، سلاحهای بیولوژیک، ساخت یا ارتقاء بیماریها، توازن جمعیت، پاندمی کرونا، مافیای علم و کنترل تولید و سانسور مقالات علمی، سایبرنتیک، جنگهای شناختی، اِنبیک و علوم نوین، و جنگ جهانی چهارم میپردازد. این مجموعه طیف گستردهای از علوم مرتبط با کنترل هوشمند و نوین جهان را مورد بررسی قرار میدهد و ارتباط این موضوعات را با شرایط اقتصاد جهانی و اعتراضات بین المللی به فقر گسترده و موضوع جهانیسازی را مورد کنکاش قرار میدهد. در این مستند از همراهی اساتید بزرگ و صاحب نامی بهره گیری شده است که عبارتنداز: دکتر شکور امیدی، دکتر کاظم فولادی، دکتر علیرضا اصلانی ذکریا ، دکتر مهتاب اسکندری، دکتر عاطفه عابدینی و مهندس محمدعلی شکوهیان راد.

عناوین هر قسمت به ترتیب به این شرح است:

قسمت اول: جهان در آشوب

قسمت دوم: توازن جمعیت و جنگهای ترکیبی، راه حلی برای تمام فصول

قسمت سوم: جلیقه زرد که باشی میمیری

قسمت چهارم: جنگ جهانی چهارم.

عوامل تولید این اثر عبارتند از: راوی: منوچهر زنده دل / مجری طرح: ستیف ربیعی / مدیرتولید: محمد حسین اکبری / فیلمبردار: محسن استیری / تدوین و صداگذاری: الهه شیرازی / آهنگساز: سهیل سلیمی / تنظیم: کیوان کریمی / موشن گرافی: سمانه ضیائی.

این مجموعه محصول موسسه فرهنگی هنری اندیشه شهید آوینی می باشد.

سهیل سلیمی / فیلمساز و متخصص مطالعات استراتژیک / مشاور رسانهای آزمایشگاه پژوهشی فضای سایبر دانشگاه تهران

عکسهای پشت صحنهی مجموعه مستند جنایت نامرئی Invisible Crime BTS_Pictures

|  |

|  |

|  |

|  |

|  |

|  |

|  |

|  |

|  |

|  |

|  |

|  |

|  |

|  |

|  |

آیا جنگ جهانی دوم را انگلیس شروع کرد؟ قسمت ششم : جنگهای ترکیبی، راهحلی برای تمام فصول نویسنده : سهیل سلیمی

آیا جنگ جهانی دوم را انگلیس شروع کرد؟

قسمت ششم : جنگهای ترکیبی، راهحلی برای تمام فصول

نویسنده : سهیل سلیمی

جنگهای امروز هم مانند جنگهای مُدرن صد سال گذشته، جنگی همه جانبه است. اما عنوان همه جانبه، امروزه هیبریدی یا ترکیبی نامیده میشود. استفاده همزمان از آسیبهای سیاسی، اقتصادی، فرهنگی و رسانهای، اجتماعی و نظامی همواره وجود داشته و وجود خواهد داشت، حتی استفاده از بیماریها در جنگها هم قدمتی تاریخی دارد، اما نداشتن حافظه تاریخی در میان ملتها باعث میشود که هر بار غافلگیری جدیدی رخ دهد. علت آنکه بسیاری از غرب زدهها از بازگویی جنایتهای غرب برای نسلهای جدید واهمه دارند و به شدت با آن مخالفت و مقابله میکنند همین است که اگر امروز نشد برای ده سال دیگر نسلی تربیت کنند که از سر ناآگاهی تن به بازیی بدهد که برای نابودی خودش طراحی شده است، نسل نا آگاه، نسلی ساده لوح و نسلی که دشمن را با بزکِ نفوذیها و رسانههای دشمن زیبا و قابل اعتماد میبیند. درست مانند همانهایی که وقتی هیتلر شروع به روشن کردن آتشِ جنگ جهانی دوم میکرد در مرزهای کشورهایشان به استقبال ارتش آلمان رفتند، یا عراقیهایی که وقتی آمریکایی وارد بغداد میشدند به دلیل آنچه نجات از دست صدام میپنداشتند برای سربازان آمریکایی گوسفند قربانی میکردند و چند سال بعد وقتی نتیجه حضور آمریکاییها شد کشتار قریب به پنج میلون کودک و نوجوان و زنان بیگناه، فهمیدند که چه بلایی به سرشان آمده، آنهم وقتی که صبح تا شب و تمام روزهای سال سرمایهی کشورشان توسط آمریکایی غارت میشود و برای تسلای خاطر برایشان شورلت و دوج و تویوتا میفرستد، که خیال کنند وسط دنیایی که برای یک بیماری ساده باید تا ترکیه یا ایران سفر کنند، خُب، ماشین خوب سوار میشوند! اما نکتهای که نباید از آن غافل شد است این است که این جنگهای ترکیبی، یک آسیب ماندگار از طریق جنگ نرم دشمن در قربانی ایجاد میکند که در لایههای مختلف جامعه تاثیری ماندگار دارد. این آسیب به آسیب شناختی معروف است و از آن به جنگ شناختی یاد میشود. در کوتاهترین جمله بندی ممکن جنگ شناختی در واقع میزان تغییر شناخت قربانی را نسبت به جهانی که تا قبل از تهاجم شناختی، میشناخته شامل میشود. هر چند تفکیک میان جنگ نرم و جنگ شناختی پیچیده است، اما شاید به لحاظ ابزار، ابزارهای نوینِ اینترنتپایه مانند اپلیکیشنهای گوشیهای همراه را در نسبت به سریالها و فیلمها که در جنگ نرم پُر رنگتر عمل میکردند، نقطهی افتراق قابل تشخیصی دانست. که در جنگ ترکیبی نوین بسیار از آنها بهرهبرداری میشود. البته باز باید تاکید کنم که از نظر بنده هیچکدام از اقدامات دشمن چیز جدیدی نیست و در راستای همان استراتژی قدیمی که در قسمت اول و دیگر قسمتها به شرح آن پرداختم، در هر دورهای دشمن ، ابزارهای نو ظهور را به کار میگیرد. برای مثال دستکاری اطلاعات، حجیمسازی اطلاعات، ارائه اطلاعات غلط، تغییر تاثیرات روانشناختی اطلاعات، چینش و مدیریت اولولیت در اطلاعات و در نهایت کنترل در مبدا تولید، در نحوه و مسیر اطلاعات، و بهرهبرداری از اطلاعات هموارهی تاریخ با ابزارهای گوناگون و برای سطوح مختلف جامعه رخ میداده اما این، ابزارِ مدیریت این فرایند بوده، که همواره تغییر کرده است. سهیل سلیمی