|| سهیل سلیمی SOHEIL SALIMI ||

| وبلاگ سهیل سلیمی نویسنده ، کارگردان و تهیهکننده | SOHEIL SALIMI's Weblog | Writer , Director & Producer |

|| سهیل سلیمی SOHEIL SALIMI ||

| وبلاگ سهیل سلیمی نویسنده ، کارگردان و تهیهکننده | SOHEIL SALIMI's Weblog | Writer , Director & Producer |سایبرنتیک و هوش مصنوعی: مسئله این است؛ برده یا ارباب!

The Machine is a Great Slave But a Bad Master. Norbert Wiener

نوربرت وینر در کتاب سایبرنتیک می نویسند:ماشین بنده ای عالی ست اما اربابی بد! در این متن به این نگاه وینر می پردازم که در آینده ای نزدیک به چالشی میان انسان و ماشین بدل خواهد شد.

سایبرنتیک و هوش مصنوعی: ماشین، بندهای عالیست اما اربابی بد !

ارائه دهند: سهیل سلیمی (مشاور رسانه ای آزمایشگاه پژوهشی فضای سایبر دانشگاه تهران)

مقدمه

سایبرنتیک، بهعنوان دانش کنترل و اعمال قدرت در انسان و ماشین، علمی میانرشتهای است که به مطالعهی مکانیزمهای تنظیم، بازخورد، و ارتباطات در سیستمهای زیستی و مصنوعی میپردازد. این رشته، که توسط نوربرت وینر در دههی 1940 پایهگذاری شد، از واژهی یونانی "kybernetes" به معنای «هدایتگر» یا «فرماندار» گرفته شده و بر چگونگی مدیریت و هدایت سیستمها تمرکز دارد. سایبرنتیک به ما امکان میدهد تا تعادل و هماهنگی بین اجزای یک سیستم، چه انسانی و چه ماشینی، را درک کرده و از آن برای بهبود عملکرد استفاده کنیم.

هوش مصنوعی (AI)، در عین حال، شاخهای از علوم کامپیوتر است که به خلق سیستمهایی اختصاص دارد که قادر به انجام وظایف شناختی مانند یادگیری، استدلال، حل مسئله، و تصمیمگیری هستند، وظایفی که بهطور سنتی به هوش انسانی نسبت داده میشوند. هوش مصنوعی از اصول سایبرنتیک، بهویژه مفاهیم بازخورد و خودتنظیمی، برای توسعهی الگوریتمهایی بهره میبرد که میتوانند از دادهها یاد بگیرند و بهصورت خودکار عملکرد خود را بهبود بخشند. این فناوری، از تشخیص الگوهای پیچیده در دادهها تا خودمختاری در سیستمهای پیشرفته، کاربردهای گستردهای دارد.

نوربرت وینر، بنیانگذار سایبرنتیک، در جملهی معروف خود اظهار داشت: «ماشین، بندهای عالیست اما اربابی بد.» این جمله نهتنها به نقش دوگانهی فناوری در خدمترسانی و سلطه اشاره دارد، بلکه چارچوبی فلسفی و عملی برای درک تعامل انسان و ماشین ارائه میدهد. این پژوهش به بررسی ارتباط سایبرنتیک و هوش مصنوعی، نقش ماشین بهعنوان ابزار خدمترسان، و خطرات بالقوهی تبدیل آن به ارباب میپردازد.

سایبرنتیک: چارچوبی برای فهم سیستمهای کنترلی

سایبرنتیک، با تمرکز بر کنترل و اعمال قدرت، اصول مشترکی بین سیستمهای زیستی (مانند مغز انسان) و سیستمهای مصنوعی (مانند ماشینهای محاسباتی) ایجاد کرد. این علم بر مفاهیمی چون بازخورد (Feedback)، خودتنظیمی (Self-regulation)، و ارتباط بین اجزای یک سیستم تأکید دارد. برای مثال، مکانیزم بازخورد منفی در سایبرنتیک به سیستمها اجازه میدهد تا با تنظیم خودکار، به حالت تعادل برسند. این مفهوم بعدها به یکی از پایههای توسعهی هوش مصنوعی تبدیل شد.

هوش مصنوعی: از ابزار سایبرنتیک تا ماشینهای خودمختار

هوش مصنوعی، با بهرهگیری از اصول سایبرنتیک، سیستمهایی خلق کرده که قادر به انجام وظایف پیچیده هستند. شبکههای عصبی مصنوعی و الگوریتمهای یادگیری عمیق، که از دادههای عظیم برای بهبود عملکرد خود استفاده میکنند، نمونههایی از این پیشرفتها هستند. با این حال، پیشرفت هوش مصنوعی چالشهایی را نیز به همراه داشته است. جملهی وینر به ما هشدار میدهد که اگرچه ماشینها میتوانند بندگان کارآمدی باشند، اما بدون کنترل مناسب، ممکن است به اربابانی تبدیل شوند که تصمیمگیریهای انسان را تحتالشعاع قرار دهند. برای مثال، سیستمهای هوش مصنوعی خودمختار در حوزههایی مانند خودروهای خودران یا سیستمهای مالی میتوانند بدون نظارت کافی، به نتایج غیرمنتظره یا حتی خطرناک منجر شوند.

ماشین بهعنوان بنده: کاربردهای سایبرنتیک و هوش مصنوعی

ماشینها، هنگامی که بهعنوان ابزار تحت کنترل انسان عمل میکنند، قابلیتهای بینظیری ارائه میدهند. در حوزهی پزشکی، الگوریتمهای هوش مصنوعی با تحلیل دادههای تصویربرداری، تشخیص بیماریهایی مانند سرطان را با دقتی بالاتر از پزشکان انسانی انجام میدهند. در صنعت، سیستمهای سایبرنتیک با استفاده از بازخورد و خودتنظیمی، فرآیندهای تولید را بهینهسازی کرده و هزینهها را کاهش دادهاند. این کاربردها نشاندهندهی نقش ماشین بهعنوان «بندهای عالی» هستند که در خدمت اهداف انسانی عمل میکند.

خطر تبدیل ماشین به ارباب

با وجود مزایای فراوان، پیشرفت سریع هوش مصنوعی و پیچیدگی روزافزون سیستمهای سایبرنتیک خطراتی را نیز به همراه دارد. یکی از نگرانیهای اصلی، کاهش کنترل انسانی بر سیستمهای خودمختار است. برای مثال، الگوریتمهای یادگیری ماشین که در شبکههای اجتماعی استفاده میشوند، میتوانند با تقویت محتوای جنجالی یا اطلاعات نادرست، بهصورت غیرمستقیم رفتارهای اجتماعی را هدایت کنند. این پدیده نشاندهندهی تبدیل شدن ماشین از یک ابزار خدمترسان به نیرویی است که میتواند بر تصمیمگیریهای انسانی تأثیر منفی بگذارد.

علاوه بر این، مسائل اخلاقی مرتبط با هوش مصنوعی، مانند سوگیری در الگوریتمها یا فقدان شفافیت در تصمیمگیریهای سیستمهای خودمختار، چالشهایی هستند که نیاز به نظارت دقیق دارند. وینر در آثار خود بر اهمیت حفظ کنترل انسانی بر ماشینها تأکید کرده و هشدار داده بود که عدم توجه به این موضوع میتواند به سلطهی ماشینها منجر شود.

راهکارها: حفظ تعادل بین انسان و ماشین

برای جلوگیری از تبدیل ماشین به ارباب، رویکردهای زیر پیشنهاد میشود:

- نظارت انسانی: طراحی سیستمهای هوش مصنوعی باید بهگونهای باشد که امکان دخالت و نظارت انسانی در تصمیمگیریهای حیاتی حفظ شود.

- شفافیت و پاسخگویی: الگوریتمهای هوش مصنوعی باید قابلتفسیر باشند تا کاربران بتوانند دلایل تصمیمگیریهای آنها را درک کنند.

- آموزش و آگاهی: توسعهدهندگان و کاربران باید از اصول سایبرنتیک و محدودیتهای هوش مصنوعی آگاه باشند تا از کاربردهای نادرست جلوگیری شود.

- قوانین و مقررات: تدوین چارچوبهای قانونی برای استفاده از هوش مصنوعی میتواند از سوءاستفادههای احتمالی جلوگیری کند.

نتیجهگیری

جملهی نوربرت وینر نهتنها یک هشدار فلسفی، بلکه یک راهنمای عملی برای توسعه و استفاده از فناوریهای سایبرنتیک و هوش مصنوعی است. سایبرنتیک، بهعنوان دانش کنترل و اعمال قدرت در انسان و ماشین، چارچوبی برای درک تعاملات پیچیدهی این دو ارائه میدهد، در حالی که هوش مصنوعی ابزارهایی قدرتمند برای حل مسائل پیچیده فراهم میکند. با این حال، برای بهرهبرداری از مزایای این فناوریها و جلوگیری از خطرات آنها، باید تعادل بین کنترل انسانی و خودمختاری ماشین حفظ شود. ماشینها باید بهعنوان بندگان انسان باقی بمانند، نه اربابانی که بر او مسلط شوند. سهیل سلیمی

منابع

- Wiener, N. (1948). Cybernetics: Or Control and Communication in the Animal and the Machine. MIT Press.

- Russell, S., & Norvig, P. (2020). Artificial Intelligence: A Modern Approach. Pearson.

- Ashby, W. R. (1956). An Introduction to Cybernetics. Chapman & Hall.

هوش مصنوعی در دو راهی انتخاب: جایی میان اخلاق، اولویت و سیستمهای سایبرنتیکی

کوتاه پیرامون فلسفه ی اخلاق در هوش مصنوعی

هوش مصنوعی در دو راهی انتخاب: جایی میان اخلاق، اولویت و سیستمهای سایبرنتیکی

مقدمه:

در عصر هوش مصنوعی، ما با پرسشی مواجهایم که تا دیروز تنها در ساحت فلسفه، دین و اخلاق زیست میکرد: «چه کسی باید نجات یابد؟» این پرسش، وقتی رنگ و بوی واقعی به خود میگیرد که در یک وضعیت بحرانی ـ مثلاً سقوط یک خودرو حاوی پنج عضو یک خانواده به درون رودخانهای یخزده ـ روبات نجاتگری مبتنی بر هوش مصنوعی، تنها توان نجات یک نفر را داشته باشد. کودک؟ مادر؟ سالخورده؟ یا آن که از نظر زیستی مقاومتر است؟

آیا ماشین تصمیم خواهد گرفت؟ و اگر بله، با چه معیاری؟

۱. سایبرنتیک و بازآرایی مفهوم تصمیم

نخست باید به چیستی «تصمیم» در بستر سایبرنتیک نگاه کنیم. سایبرنتیک، به تعبیر نوربرت وینر، علم فرمان، کنترل و ارتباط در موجودات زنده و ماشینهاست. در این چارچوب، هر کنش، بازخوردی دارد؛ و هر تصمیم، حاصل شبکهای از اطلاعات، وزنها و حلقههای بازخوردی است.

در یک سیستم سایبرنتیکی، اولویت نه براساس «احساس» بلکه براساس الگوریتمی از ورودیها و خروجیها تعیین میشود. بنابراین روبات نجاتگر، ممکن است تابعی از این جنس داشته باشد:

نجات کسی که کمترین انرژی برای نجاتش لازم است و بالاترین احتمال بقاء را دارد.

یا:

نجات فردی که در شبکه اطلاعاتی، دارای بیشترین ارزش اجتماعی یا ژنتیکی (بر اساس دادههای آماری آموزشدیده) شناخته شده است.

در اینجا اخلاق، از درون شبکه تصمیمسازی به بیرون پرتاب میشود، مگر آنکه اخلاق، خود به دادهای قابل رمزگذاری تبدیل شده باشد.

۲. اخلاق بهمثابه داده: آیا ممکن است؟

سؤال اساسی این است که آیا «اخلاق» را میتوان به الگوریتم تبدیل کرد؟ اگر پاسخ منفی باشد، پس سیستمهای مبتنی بر هوش مصنوعی هرگز اخلاقی تصمیم نخواهند گرفت، بلکه صرفاً بر اساس «اولویتهایی برنامهریزیشده» عمل خواهند کرد.

اما اگر بپذیریم که میتوان اخلاق را در قالب قواعدی فرمال و قابل محاسبه فرموله کرد (نظیر اخلاق وظیفهگرای کانتی، یا اخلاق پیامدگرای بنتامی)، آنگاه شاید بتوان امید داشت که روبات نجاتگر، تصمیمی «اخلاقی» بگیرد.

مثلاً، بر اساس اخلاق وظیفهگرا، نجات کودک به عنوان موجودی بیگناه و ناتوان، یک وظیفه اخلاقی بیقید و شرط است. اما در نگاه پیامدگرایانه، نجات مادر ممکن است توجیهپذیر باشد زیرا او میتواند فرزندان دیگر را در آینده تربیت کند.

در هر دو صورت، اخلاق دیگر حس یا الهام نیست، بلکه تابعی ریاضیاتی و سایبرنتیکی از اهداف سیستم است.

۳. احساسات: خطای سیستم یا سیگنالی فراتر از منطق؟

در انسان، احساسات نقش حیاتی در تصمیمگیری دارند. ما از روی شفقت، عشق، ترس، وفاداری یا اندوه تصمیم میگیریم؛ تصمیمهایی که اغلب در تضاد با منطق سرد هستند. سایبرنتیک در فرم کلاسیکش، احساس را اغلب بهعنوان نویز یا اختلال در سیستم در نظر میگیرد، اما در نسخههای نوین و بینارشتهای، احساس بهمثابه سیگنالی نرم برای تنظیم وزنهای تصمیم دیده میشود.

هوش مصنوعی میتواند یاد بگیرد که احساسات را تقلید کند (همدلسازی)، اما نمیتواند واقعاً «احساس» داشته باشد. این تفاوت، در لحظه بحران، تعیینکننده است: روبات دچار تردید نمیشود، پشیمان نمیشود، و خاطرهای از آن لحظه در ضمیر ناخودآگاهش نمیسازد. این «نبود عذاب وجدان»، مزیت کاراییست، اما خلأ اخلاقی را نیز آشکار میسازد.

۴. رسانه و بازنمایی انتخاب اخلاقی در هوش مصنوعی

در جهان امروز، رسانهها نقش چشمگیری در شکلدادن به تصویر عمومی از هوش مصنوعی دارند. روایتهایی که از روباتهای نجاتگر در فیلمها و داستانها میبینیم، اغلب با ترس، تحسین یا پرسش همراهاند. رسانه با بازنمایی موقعیتهای بحرانی، ما را با مسئله «انتخاب» در برابر چشم هوشمند و بیروح ماشین مواجه میکند. این بازنماییها نهتنها افکار عمومی، بلکه مسیر توسعه فناوری را نیز جهت میدهند. اگر جامعه بخواهد روبات نجاتگر بر اساس «احساس» تصمیم بگیرد، توسعهدهندگان در پاسخ، احساس را شبیهسازی خواهند کرد.

اینجاست که «بازخورد رسانهای» به بخشی از سیستم سایبرنتیکی توسعه فناوری تبدیل میشود.

در نهایت، باید بپذیریم که هوش مصنوعی، در وضعیت دو راهی اخلاقی، به گونهای تصمیم خواهد گرفت که از پیش توسط ما ـ برنامهریزان و طراحان ـ درون الگوریتمهایش کاشته شده است. اگر ما اخلاق را به زبان داده ترجمه نکنیم، ماشین تنها بر اساس اولویتهای فنی تصمیم خواهد گرفت.

بنابراین، مسئولیت تصمیم هوش مصنوعی، نه با خودش، بلکه با ماست. و این، نه صرفاً مسئلهای فنی، بلکه عمیقاً رسانهای، اخلاقی و سایبرنتیکیست.

سایبرنتیک، هوش مصنوعی و بحران حقیقت در رسانه | کنترل گر آگاه یا مصرف کننده منفعل

سایبرنتیک، هوش مصنوعی و بحران حقیقت در رسانه

نویسنده: سهیل سلیمی

از میانه قرن بیستم، نظریه سایبرنتیک به عنوان علمی میانرشتهای در تبیین سیستمهای کنترل، بازخورد و ارتباطات انسان و ماشین پا به عرصه گذاشت. نوربرت وینر، پدر علم سایبرنتیک، این علم را ناظر بر الگوهای ارتباط و کنترل در موجودات زنده و ماشینها دانست. امروزه، با اوجگیری هوش مصنوعی، مفاهیم سایبرنتیک نه تنها جنبه نظری ندارند، بلکه به شکل ملموسی در بطن سیستمهای هوشمند و الگوریتمهای تولید محتوا بازتولید شدهاند.

سایبرنتیک و هوش مصنوعی: از نظریه تا واقعیت

سایبرنتیک بهواسطه تمرکز بر بازخورد، تطبیقپذیری و کنترل، بستر فکری و مفهومی مهمی برای توسعه هوش مصنوعی فراهم کرد. در واقع، الگوریتمهای یادگیری ماشین و شبکههای عصبی مصنوعی امروز، بازتابی از مفاهیم سایبرنتیکی هستند: سیستمهایی که از دادهها بازخورد میگیرند، الگوها را شناسایی میکنند و رفتار خود را اصلاح میکنند.

در این چارچوب، رسانهها نیز به عنوان سیستمهایی سایبرنتیکی قابل تحلیلاند. آنها داده (توجه، کلیک، پسندیدن، بازنشر) دریافت میکنند، از طریق الگوریتمها آن را پردازش میکنند و محتوای جدید تولید مینمایند—چرخهای که به طور فزایندهای توسط هوش مصنوعی تسهیل میشود.

آسیبشناسی استفاده گسترده از هوش مصنوعی در تولید رسانه

گرچه هوش مصنوعی توانسته در عرصه تولید محتوا کارایی و سرعت را بالا ببرد، اما این توسعه، بدون تبعات نیست. در ادامه برخی از مهمترین آسیبهای این پدیده را مرور میکنیم:

۱. زوال مرز میان واقعیت و خیال

با قدرت فزاینده هوش مصنوعی در تولید متن، صدا، تصویر و ویدیو، تفکیک میان محتوای واقعی و ساختگی دشوار شده است. فناوریهایی چون «دیپفیک» یا متون ماشینی که شبیه نویسندگان واقعی نوشته میشوند، نوعی بحران اعتماد به رسانهها پدید آوردهاند.

۲. خودتقویتی الگوریتمی و پژواکخانهها

الگوریتمهای مبتنی بر هوش مصنوعی بر اساس بازخوردهای گذشته کار میکنند. اگر کاربری محتوایی خاص را بپسندد، سیستم محتواهای مشابه بیشتری به او ارائه میدهد. این پدیده که در سایبرنتیک با مفهوم بازخورد مثبت شناخته میشود، منجر به ایجاد "پژواکخانههای رسانهای" میشود؛ محیطهایی که در آن تنها صداهای موافق شنیده میشود و فرد از مواجهه با دیدگاههای متفاوت محروم میگردد.

۳. تضعیف خلاقیت انسانی

هوش مصنوعی قادر به تقلید از سبکهای نوشتاری، بصری و صوتی است؛ اما در اغلب موارد، فاقد شهود، تجربه و بینش انسانی است. تکیه صرف بر تولید ماشینی محتوا میتواند به فرسایش خلاقیت، اصالت و روایتگری انسانی در رسانهها بینجامد.

۴. تسخیر میدان ارتباطی توسط پلتفرمها

اکوسیستم رسانهای امروز در دست چند پلتفرم بزرگ جهانی است که با استفاده از هوش مصنوعی، جریان اطلاعات را کنترل میکنند. این تمرکز قدرت، با اصول ارتباط آزاد و توزیعشده سایبرنتیک در تضاد است و موجب آسیبپذیری فرهنگی، سیاسی و اقتصادی جوامع میشود.

جمعبندی: بازگشت به سایبرنتیک برای فهم بهتر آینده

برای فهم بهتر مسیر پیشرو، بازگشت به مفاهیم سایبرنتیکی ضروری است. سایبرنتیک نه تنها در درک نحوه کار سیستمهای هوش مصنوعی به ما کمک میکند، بلکه ابزار تحلیلی قدرتمندی برای نقد عملکرد رسانهها، الگوریتمها و ساختارهای قدرت در اختیار ما میگذارد.

هوش مصنوعی میتواند ابزار توانمندی برای تقویت خلاقیت انسانی و دسترسی عادلانه به اطلاعات باشد، اما تنها در صورتی که ما به نقش خود به عنوان کنترلگر آگاه در این سیستم توجه کنیم—نه صرفاً دریافتکننده منفعل محتوا.

مدیا سایبرنتیک و هوش مصنوعی

مدیا سایبرنتیک و هوش مصنوعی

رابطه سایبرنتیک، هوش مصنوعی، و رسانه: کنترل و اعمال قدرت (سهیل سلیمی)

سایبرنتیک، به عنوان دانش کنترل و اعمال قدرت و ارتباطات در سیستمهای پیچیده، از زمان طرحشدن توسط نوربرت وینر، تحولات عمیقی را در عرصههای علمی، فناوری، و اجتماعی ایجاد کرده است. امروزه، با ظهور هوش مصنوعی و گسترش رسانههای دیجیتال، این دانش به سطحی بیسابقه از کاربرد و تاثیرگذاری رسیده است. در این نوشته، به بررسی رابطه سهگانه سایبرنتیک، هوش مصنوعی، و رسانه میپردازم و نشان میدهم که چگونه این ترکیب، به ابزاری قدرتمند برای کنترل و اعمال قدرت در جوامع مدرن تبدیل شده است.

سایبرنتیک و هوش مصنوعی: چارچوبی برای کنترل

سایبرنتیک بر مفهوم بازخورد (Feedback) و خودتنظیمی سیستمها تاکید دارد. هوش مصنوعی، با الهام از این اصول، سیستمهایی را طراحی میکند که قادر به یادگیری، تطبیق، و تصمیمگیری هستند. این سیستمها از الگوریتمهای پیچیده برای پردازش دادهها استفاده میکنند و با تحلیل رفتار کاربران، الگوهای کنترل را بهینهسازی مینمایند. برای مثال، شبکههای عصبی مصنوعی با شبیهسازی مغز انسان، توانایی پیشبینی و تاثیرگذاری بر رفتارهای اجتماعی را دارند.

رسانه به عنوان ابزار تلقین و کنترل

رسانهها، به ویژه در عصر دیجیتال، نقش کلیدی در انتقال پیامهای کنترلگرانه ایفا میکنند. با استفاده از هوش مصنوعی، رسانهها قادر به شخصیسازی محتوا و هدفگیری دقیق مخاطبان هستند. این فرآیند، که به "مهندسی رضایت" معروف است، از طریق تحلیل دادههای کاربران و ارائه محتوای متناسب با ترجیحات و باورهای آنها انجام میشود. برای نمونه، الگوریتمهای فیسبوک و گوگل با نمایش انتخابی اخبار و تبلیغات، میتوانند افکار عمومی را جهتدهی کنند. که در مجموع من این اعمال قدرت و کنترل از طریق رسانه را مدیاسایبرنتیک می دانم.

چرخه کنترل و اعمال قدرت

در این سیستم، یک چرخه دائمی بین سایبرنتیک، هوش مصنوعی، و رسانه وجود دارد:

1. **جمعآوری دادهها**: هوش مصنوعی با رصد رفتار کاربران در رسانههای اجتماعی، دادههای عظیمی را جمعآوری میکند.

2. **تحلیل و پیشبینی**: این دادهها برای شناسایی الگوهای رفتاری و پیشبینی تمایلات آینده استفاده میشوند.

3. **تلقین و کنترل**: رسانهها با استفاده از این تحلیلها، محتوایی را منتشر میکنند که باورها و رفتارهای مخاطبان را شکل میدهد.

4. **بازخورد و بهینهسازی**: نتایج این تاثیرگذاری، دوباره به سیستم بازگردانده میشود تا چرخه کنترل تقویت شود.

پیامدهای اجتماعی و اخلاقی

این رابطه سهگانه، پیامدهای عمیقی برای آزادی فردی و دموکراسی دارد. از یک سو، هوش مصنوعی و رسانهها میتوانند به بهبود خدمات و رفاه اجتماعی کمک کنند، اما از سوی دیگر، خطر تبدیل شدن به ابزارهای نظارت و دستکاری افکار عمومی را نیز به همراه دارند. مثال بارز این موضوع، استفاده از رسانههای اجتماعی برای تاثیرگذاری بر نتایج انتخابات یا ایجاد قطبیسازی سیاسی است.

نتیجهگیری

ترکیب سایبرنتیک، هوش مصنوعی، و رسانه، یک سیستم کنترل قدرتمند را ایجاد کرده است که همزمان هم فرصتها و هم تهدیدهایی را برای جامعه به ارمغان میآورد. درک این رابطه برای حفظ تعادل بین پیشرفت فناوری و حریم خصوصی افراد ضروری است. آینده این تعامل، به چگونگی تنظیم مقررات اخلاقی و قانونی برای استفاده از این فناوریها بستگی خواهد داشت.

سهیل سلیمی - مشاور رسانه ای آزمایشگاه پژوهشی فضای سایبر دانشگاه تهران

این نوشته بخشی از سخنرانی من در کنفرانس فضای سایبر سال 1403 می باشد.

**کلمات کلیدی**: سایبرنتیک، هوش مصنوعی، رسانه، کنترل اطلاعاتی، مهندسی رضایت، نظارت دیجیتال، آزادی فردی.

خلاصه کتاب سایبرنتیک – نوربرت وینر Norbert Wiener: Cybernetics: Or Control and Communication in the Animal and the Machine

خلاصه کتاب سایبرنتیک – نویسنده: نوربرت وینر Norbert Wiener

عنوان اصلیCybernetics: Or Control and

Communication in the Animal and the Machine (1948)

ارائه دهند: سهیل سلیمی (مشاور رسانه ای آزمایشگاه پژوهشی فضای سایبر دانشگاه تهران)

مقدمهای بر کتاب

نوربرت وینر در این کتاب، پایههای یک علم نوین به نام سایبرنتیک (Cybernetics) را بنیانگذاری میکند؛ دانشی میانرشتهای که به بررسی سیستمهای کنترل و ارتباطات در موجودات زنده و ماشینها میپردازد. هدف این علم، درک چگونگی تنظیم، تطبیق، و بازخورد (feedback) در سیستمهاست.

مفاهیم کلیدی کتاب

1. سایبرنتیک چیست؟

سایبرنتیک از واژهای یونانی به معنی «سکانداری» گرفته شده و به علم کنترل و ارتباط در موجود زنده و ماشین اشاره دارد. این علم تلاش دارد تا شباهتها و اصول مشترک بین عملکرد مغز انسان، سیستم عصبی، و ماشینهای خودکار را کشف کند.

2. بازخورد (Feedback)

در قلب سایبرنتیک، مفهوم بازخورد قرار دارد. این ایده میگوید که سیستمها از نتایج اعمال خود مطلع میشوند و بر اساس آن نتایج، رفتار خود را تنظیم میکنند.

مثال: وقتی یک ترموستات دمای خانه را حس میکند و بر اساس آن، سیستم گرمایشی را خاموش یا روشن میکند، از بازخورد استفاده کرده است.

3. اطلاعات بهمثابه کمیت علمی

وینر به کمک نظریه اطلاعات

(از کلود شانون)، اطلاعات را بهعنوان یک مفهوم قابل اندازهگیری معرفی میکند.

اطلاعات، نقشی مشابه انرژی

در فیزیک دارد، اما در حوزه ارتباط و کنترل.

4. احتمال، عدم قطعیت و پیشبینی

در بسیاری از سیستمها (از جمله مغز انسان یا اقتصاد)، رفتار آینده با قطعیت قابل پیشبینی نیست. سایبرنتیک تلاش میکند با استفاده از روشهای آماری و احتمالات، در چنین شرایطی نیز الگوهایی برای کنترل و تصمیمگیری پیدا کند.

5. سیستمهای خودکار و ماشینهای هوشمند

وینر درباره ماشینهایی صحبت میکند که میتوانند تصمیم بگیرند، خطاهای خود را اصلاح کنند، و با محیط تعامل داشته باشند. این دیدگاه، پایهگذار مفاهیمی شد که بعدها در هوش مصنوعی، رباتیک و سیستمهای تطبیقی توسعه یافت.

6. مقایسه ماشین و انسان

او سعی میکند شباهتهای میان مغز انسان و ماشینهای پیچیده را بررسی کند. البته تأکید دارد که انسانها دارای احساسات و وجوه انسانیاند، اما از نظر کنترل و ارتباط، میتوان الگوهای مشترکی یافت.

7. اخلاق سایبرنتیک

در پایان، وینر هشدارهایی اخلاقی درباره استفاده از دانش سایبرنتیک میدهد:

- باید از این علم برای تقویت تواناییهای انسان استفاده شود، نه جایگزینی او.

- خطر سوءاستفاده از تکنولوژی برای کنترل اجتماعی یا جنگ وجود دارد.

- مسئولیت علمی و اخلاقی دانشمندان برجسته است.

دستاوردها و تأثیر کتاب

این کتاب نهتنها پایهگذار علم سایبرنتیک شد، بلکه بر زمینههای مختلفی مثل:

- هوش مصنوعی

- مدارهای کنترل خودکار

- علوم شناختی و مغز

- زیستشناسی سامانهای

- و حتی اقتصاد و جامعهشناسی تأثیر گذاشت.

جمعبندی

نوربرت وینر در این کتاب بنیان مفهومی را گذاشت که ما امروز در انواع فناوریهای هوشمند، سیستمهای کنترل، اینترنت اشیاء، و حتی درک ذهن و مغز انسان با آن مواجهایم. سایبرنتیک پلی میان ماشین و انسان، فیزیک و روانشناسی، و کنترل و ارتباط است.

سهیل سلیمی

خلاصه کتاب سایبرنتیک – نویسنده: نوربرت وینر Norbert Wiener

Cybernetics: Or Control and Communication in the Animal and the Machine

✅ فصل ۱: پیام، معنا و نویز

این فصل به نقش اطلاعات در ارتباطات میپردازد. وینر توضیح میدهد که ارتباط بین انسان یا ماشین بر پایه ارسال پیامها است، و این پیامها همیشه در معرض نویز یا اختلال قرار دارند. او نظریهی اطلاعات شانون را به کار میگیرد تا نشان دهد چگونه میتوان پیامها را به شکلی مؤثر و بدون خطا منتقل کرد.

✅ فصل ۲: ارتباط در موجود زنده و ماشین

اینجا وینر بحث را به شباهتهای مغز و کامپیوتر میبرد. او استدلال میکند که هم موجودات زنده و هم ماشینها میتوانند اطلاعات را پردازش کنند. مغز انسان مانند یک ماشین محاسباتی است که اطلاعات حسی را دریافت کرده، پردازش کرده و واکنش مناسب نشان میدهد.

✅ فصل ۳: رفتار، هدف و تلئولوژی

این فصل درباره رفتار هدفمند است. در سایبرنتیک، رفتارهایی که بهسمت یک هدف مشخص حرکت میکنند (مثل راه رفتن بهسمت غذا)، مورد توجه قرار میگیرند. وینر مفهوم بازخورد (feedback) را معرفی میکند: مکانیزمی که سیستمها برای رسیدن به هدف خود، مدام خود را تنظیم میکنند.

✅ فصل ۴: الگوها و سازمان

در این فصل، بحث بر سر این است که اطلاعات نهفقط کمیت، بلکه ساختار و الگو دارند. وینر میگوید موجودات زنده و ماشینها، اطلاعات را نهفقط ذخیره، بلکه سازماندهی و ساختاربندی میکنند. او از سیستمهای عصبی و ارتباطات ماشینی مثالهایی میزند.

✅ فصل ۵: سایبرنتیک و فیزیولوژی سیستم عصبی

یکی از مهمترین فصلهای کتاب. وینر کارکرد سیستم عصبی انسان را از منظر سایبرنتیکی بررسی میکند. مثلاً چگونه مغز پیامها را از حواس دریافت میکند، تصمیم میگیرد و سپس دستور عمل میفرستد. او تأکید میکند که این فرآیند بسیار شبیه سیستم کنترل خودکار در ماشینهاست.

✅ فصل ۶: سایبرنتیک و آسیبشناسی سیستم عصبی

در اینجا، وینر از بیماریها و آسیبهایی صحبت میکند که عملکرد سیستم عصبی را مختل میکنند، مثل پارکینسون یا صرع. این فصل نشان میدهد که اختلال در بازخورد یا ارتباط عصبی میتواند به بیماری منجر شود، مشابه یک ماشین که وقتی سیستم کنترلیاش از کار بیفتد، خراب میشود.

✅ فصل ۷: یادگیری و حافظه در انسان و ماشین

فصل جذابی که به مسئله یادگیری ماشین و یادگیری انسانی میپردازد. وینر توضیح میدهد که چگونه ماشینها میتوانند یاد بگیرند، با استفاده از بازخورد و اصلاح خطا. او حافظه را بهعنوان ذخیرهساز اطلاعات معرفی میکند و مقایسهای میان مغز و حافظه دیجیتال انجام میدهد.

✅ فصل ۸: سیستمهای آماری و پیشبینی رفتار

در این فصل، وینر به سراغ احتمالات، عدم قطعیت و مدلسازی آماری میرود. در بسیاری از شرایط، آینده قابل پیشبینی دقیق نیست، اما با استفاده از آمار میتوان رفتار سیستمها را تا حدی پیشبینی کرد. این اصل در اقتصاد، هواشناسی، و حتی روانشناسی کاربرد دارد.

✅ فصل ۹: انسان و ماشین

در این فصل فلسفی، وینر پرسشهایی عمیق مطرح میکند:

- آیا ماشینها میتوانند جای انسان را بگیرند؟

- آیا باید از تکنولوژی بترسیم؟

- او نتیجه میگیرد که ماشینها باید ابزار انسان باقی بمانند، و اخلاق، تصمیمگیری و احساسات، ویژگیهایی هستند که هنوز مختص انساناند.

✅ فصل ۱۰: جنگ و مسئولیت علمی

در بخش پایانی، وینر نگرانی خود را درباره استفاده نظامی از دانش سایبرنتیک بیان میکند. او میگوید:

«علم بدون اخلاق، میتواند فاجعهبار باشد.»

وی دانشمندان را به داشتن مسئولیت اجتماعی فرا میخواند، خصوصاً در دنیای پس از جنگ جهانی دوم.

✅ فصل ۱۱: نتیجهگیری کلی

کتاب با تأکیدی دوباره بر اهمیت سایبرنتیک در دنیای مدرن پایان مییابد. وینر معتقد است که در عصر ارتباطات، انسان باید یاد بگیرد که چگونه با ماشینها و با دیگر انسانها بهشکلی هوشمندانه و اخلاقی تعامل کند.

دوره خصوصی تولید محتوا Advance Content Creation - Pro Mobile CineTography - ACC - PMCT

دورههای خصوصی ACC - PMCT تولید محتوا با موبایل.

از صفر تا صد (خصوصی) در دو سطح حرفه ای و فوق پیشرفته، آموزش اختصاصی در محل شما (تهران و حومه)، ساخت محتوا با امکانات خودتان!

آماده همکاری با مراکز دولتی و آموزشگاهها برای ارتقا سواد رسانه ای کارمندان و کارکنان. و ایجاد مهارت تولید محتوای سازمانی

سطح حرفهای: عکاسی و فیلمبرداری موبایل (Professional Mobile CineTography)

با موبایل خود حرفهای کار کنید:

اصول نورپردازی و ترکیببندی پیشرفته

تنظیمات حرفهای دوربین موبایل - تبدیل گوشی شما به یک استودیو همراه

تکنیکهای فیلمبرداری دینامیک از ویدئوهای ساده تا تولیدات حرفهای

سطح فوقپیشرفته ACC: تولید محتوای هوشمند.

(Advance Content Creation)

ترکیب هنر، فناوری و خلاقیت

عکاسی و فیلمبرداری موبایل (Professional Mobile CineTography)

تدوین و صداگذاری - ساخت محصولات رسانهای با موبایل

نویسندگی و اجرای محتوا - از ایده تا مدیا

آموزش استفاده از هوش مصنوعی در تولید محتوا

دستیابی به توانایی تولید محتوای حرفهای

ویژگیها:

✔️ آموزش کاملاً خصوصی و متناسب با نیازهای شما

✔️ گواهینامه پایان دوره از (نویسنده و کارگردان سینما و تلویزیون)

✔️ پشتیبانی پس از دوره

هزینه سطح حرفه ای 7.9 هفت میلیون و نه صد هزار تومان

هزینه سطح فوق پیشرفته 18.5 هجده و نیم میلیون تومان

سطح حرفهای هفت جلسه و سطح فوق پیشرفته بیست جلسه میباشد.

برای هماهنگی به آیدی یا شماره موبایل زیر پیام بدهید:

eitaa.com/SOHEILSALIMI1

09939494184

نابغه ایرانی

نابغه ایرانی

ابن هیثم: پدر نورشناسی مدرن و چهرهی درخشان فیزیک جهان اسلام

مقدمه

ابوعلی محمد بن حسن بن هیثم بصری، مشهور به ابن هیثم (۳۵۴-۴۳۰ هجری قمری/۹۶۵-۱۰۴۰ میلادی)، از بزرگترین دانشمندان جهان اسلام و یکی از تأثیرگذارترین چهرههای تاریخ علم به شمار میرود. او که به "پدر نورشناسی مدرن" شهرت یافته، نه تنها در فیزیک، بلکه در ریاضیات، نجوم، مهندسی و فلسفه نیز دستاوردهای شگرفی داشته است. من به دلیل علاقه ی شخصی ام این مقاله به بررسی گوشه ای از زندگی علمی او و دستاوردهای این نابغهی جهان اسلام میپردازم.

زندگی و دوران علمی ابن هیثم

ابن هیثم در سال ۳۵۴ هجری قمری (۹۶۵ میلادی) در بصره به دنیا آمد و در دوران طلایی تمدن اسلامی پرورش یافت؛ دورهای که شاهد شکوفایی علوم مختلف و ترجمهی آثار یونانی، فارسی و هندی به زبان عربی بود . او ابتدا به تحصیل علوم دینی پرداخت، اما به تدریج به علوم تجربی گرایش پیدا کرد. ابن هیثم در بصره منصب دیوانی داشت، اما برای پرداختن به علم، تظاهر به جنون کرد تا از این سمت برکنار شود .

داستان مهاجرت او به مصر و مواجهه با خلیفه الحاکم فاطمی از جذابترین بخشهای زندگی اوست. ابن هیثم با ادعای توانایی تنظیم جریان نیل به مصر دعوت شد، اما پس از بررسیهای میدانی به غیرعملی بودن این طرح پی برد. از ترس خشم خلیفه، بار دیگر تظاهر به جنون کرد و حدود ده سال تحت حبس خانگی قرار گرفت . جالب اینجاست که همین دوران حبس، پربارترین دورهی علمی زندگی او بود و در این مدت کتاب مشهور "المناظر" را تألیف کرد .

دستاوردهای علمی ابن هیثم

۱. انقلابی در نورشناسی

ابن هیثم را میتوان بنیانگذار نورشناسی مدرن دانست. او در کتاب هفت جلدی "المناظر" (کتاب نورشناسی) که بین سالهای ۱۰۱۱ تا ۱۰۲۱ میلادی نوشته شد، نظریهای انقلابی دربارهی بینایی ارائه داد . برخلاف نظریههای رایج آن زمان که معتقد بودند نور از چشم خارج میشود (نظریهی انتشار)، ابن هیثم ثابت کرد که نور از اجسام به چشم میتابد (نظریهی درونتابی) . او همچنین:

- قوانین بازتاب نور را به طور کامل فرمولبندی کرد

- به بررسی دقیق پدیدهی شکست نور پرداخت

- ویژگیهای عدسیها و آینهها را مطالعه کرد

- ماهیت رنگها و ارتباط آنها با نور را توضیح داد

۲. اختراع دوربین تاریکخانهای (Camera Obscura)

ابن هیثم اولین کسی بود که از اتاق تاریک (Albeit Almuzlim) برای مطالعهی نور و تصویر استفاده کرد. این دستگاه که بعدها به نام Camera Obscura شناخته شد، اساس اختراع دوربین عکاسی و سینما در قرنهای بعد گردید . او با این اختراع نشان داد که نور در خطوط مستقیم حرکت میکند و تصاویر به صورت وارونه تشکیل میشوند .

۳. روش علمی تجربی

ابن هیثم را میتوان پیشگام روش علمی مدرن دانست. او پنج قرن قبل از دانشمندان رنسانس، روشی مبتنی بر مشاهده، فرضیهسازی، آزمایش و استنتاج منطقی را پایهگذاری کرد . رویکرد او در علم، ترکیبی از ریاضیات و آزمایش بود که در آن زمان کاملاً نوآورانه محسوب میشد. ابن هیثم معتقد بود: "اگر یادگیری حقیقت هدف دانشمند است... پس باید خود را دشمن همهی آنچه میخواند قرار دهد" .

۴. دستاوردهای ریاضی و نجوم

ابن هیثم در ریاضیات نیز نوآوریهای مهمی داشت:

- حل مسئلهی معروف "مسئلهی الحسن" (Alhazen's problem) در هندسه

- توسعهی روشهای محاسبهی مساحت و حجم اجسام سهبعدی

- پیشرفت در نظریهی اعداد و محاسبات مثلثاتی

در نجوم، او به نقد نظریههای بطلمیوس پرداخت و در کتاب "الشکوک علی بطلمیوس" (شکهای دربارهی بطلمیوس) به ناسازگاریهای مدل نجومی بطلمیوس اشاره کرد . همچنین اندازهگیریهای دقیقی از سرعت نور و صوت انجام داد و محیط کرهی زمین را با واحد ذرع (واحد طول رایج در آن زمان) محاسبه کرد .

۵. تأثیر بر علوم دیگر

ابن هیثم در زمینههای دیگری نیز تأثیرگذار بود:

- پزشکی: مطالعهی ساختار و عملکرد چشم

- فلسفه: تلفیق روشهای تجربی با فلسفهی طبیعی

- روانشناسی: بررسی ادراک بصری و خطاهای دید

میراث و تأثیر جهانی ابن هیثم

آثار ابن هیثم، به ویژه کتاب "المناظر"، تأثیر شگرفی بر رشد علم در غرب داشت. ترجمهی لاتین این کتاب در قرن ۱۲ و ۱۳ میلادی به دسترس دانشمندان اروپایی قرار گرفت و الهامبخش چهرههایی مانند راجر بیکن، یوهانس کپلر، رنه دکارت و حتی اسحاق نیوتن شد . برخی مورخان علم، کتاب المناظر را همتراز "اصول ریاضی فلسفهی طبیعی" نیوتن در تأثیرگذاری بر علم فیزیک میدانند .

یونسکو در سال ۲۰۱۵ که به عنوان "سال جهانی نور" نامگذاری شده بود، از ابن هیثم به عنوان یکی از پیشگامان علم نورشناسی تجلیل کرد. این سال مصادف با هزارمین سالگرد تألیف کتاب المناظر بود . همچنین دهانهای در کرهی ماه و یک سیارک به نام او (Alhazen) نامگذاری شدهاند .

نتیجهگیری

ابن هیثم به حق یکی از بزرگترین فیزیکدانان جهان اسلام و تاریخ علم به شمار میرود. نوآوریهای او در نورشناسی، روش علمی تجربی و ریاضیات، بنیانهای علم مدرن را شکل داد. داستان زندگی او - از تظاهر به جنون برای پرداختن به علم تا دستاوردهای شگفتانگیزش در دوران حبس خانگی - الهامبخش همهی جویندگان علم و حقیقت است. امروزه، با وجود گذشت حدود هزار سال از مرگ او در سال ۴۳۰ هجری (۱۰۴۰ میلادی) در قاهره، آثار و افکار ابن هیثم همچنان زنده و تأثیرگذار است و نام او به عنوان نماد شکوفایی علمی تمدن اسلامی میدرخشد. سهیل سلیمی

گذاری کوتاه در فلسفله اخلاق در هوش مصنوعی

نقش ساختار شبکهای قدرت و بازخورد اجتماعی در شکلگیری تصمیمات هوش مصنوعی. گذاری کوتاه در فلسفله اخلاق در هوش مصنوعی. سهیل سلیمی

هوش مصنوعی و سایبرنتیک قدرت: تصمیمی که از میدان نیرو میآید، نه از عقل فردی

مقدمه: وقتی تصمیم، یک خروجی فردی نیست

ما در مواجهه با مسئلهٔ انتخاب اخلاقی توسط هوش مصنوعی، اغلب فرض میکنیم که ماشین در موقعیتی منفرد قرار دارد، جایی که با تحلیل دادهها، تصمیم نهایی را اتخاذ میکند. اما اگر به جای نگاه کردن به هوش مصنوعی بهمثابه «ذهنی جدا»، آن را همچون «گرهای در شبکهای پیچیده از قدرت، داده و بازخورد اجتماعی» ببینیم، آنگاه پرسش اخلاقی ما نیز دگرگون میشود.

در واقع، ممکن است تصمیمی که در لحظهٔ نجات گرفته میشود، پیشاپیش از قبل، در لایههای پنهانتر شبکهای ـ از سوگیری دادهها گرفته تا جهتگیریهای سیاسی، اقتصادی و فرهنگی ـ شکل گرفته باشد.

بازگشت به سایبرنتیک بهمثابه میدان نیرو

سایبرنتیک، در معنای عمیقتر، تنها یک علم دربارهٔ کنترل و فرمان نیست؛ بلکه مطالعهایست دربارهٔ اینکه چگونه نیروها از طریق اطلاعات، به همدیگر جهت میدهند. وقتی ما یک ماشین نجاتگر طراحی میکنیم، آنچه تعیین میکند چه کسی نجات یابد، فقط الگوریتم نیست؛ بلکه میدان پیچیدهایست از نیروهای سیاسی، طبقاتی، نژادی و رسانهای که از طریق دادهها خود را تحمیل میکنند.

مثلاً اگر در یک پایگاه دادهی آموزش ماشین، نجات کودک سفیدپوست در فیلمهای هالیوودی بیشتر نمایش داده شده باشد، این ماشین ناخودآگاه به الگوی خاصی از "ارزش انسانی" شرطی شده است، حتی اگر در ظاهر، تابع هیچ ایدئولوژی نباشد.

تصمیم هوش مصنوعی، بازتابی از نظم اجتماعی؟

تصور کنید در همان صحنهٔ سقوط خودرو، پنج نفر داخل ماشین متعلق به طبقهٔ فرودست جامعهاند. آیا احتمال دارد الگوریتم، حتی بیآنکه از طبقهٔ اجتماعی اطلاعی داشته باشد، دادههایی در اختیار داشته باشد که غیرمستقیم این موقعیت را بازتولید کنند؟

هوش مصنوعی، بر اساس دادههایی که از جهان دریافت کرده، جهان را بازسازی میکند. اما این دادهها بیطرف نیستند؛ آنها حامل ارزشها، اولویتها و گاه تبعیضهای ساختاریاند. تصمیم ماشین، حتی اگر «عقلانی» بهنظر برسد، ممکن است چیزی جز بازتولید نظم نابرابر قدرت نباشد.

مسئله مسئولیت در سیستمهای غیرمتمرکز

در مدل سایبرنتیکیِ کلاسیک، یک نهاد یا فرمانده وجود دارد که مرکز تصمیمسازی است. اما در سامانههای امروزیِ مبتنی بر یادگیری عمیق، دادهها از میلیونها منبع تغذیه میشوند. تصمیم نهایی هوش مصنوعی ممکن است محصول میلیونها بازخورد از کاربران، سیستمهای ترجیحی، وزندهی شبکهای و الگوریتمهای نامرئی باشد.

بنابراین، نمیتوان پرسید: «این تصمیم را چه کسی گرفت؟»

پرسش درست این است: «چه شبکهای، این تصمیم را ممکن ساخت؟»

و در اینجا، مسئولیت اخلاقی، پراکنده میشود ـ نه گم میشود، بلکه در لایههایی پنهان میشود که بهآسانی قابل ردیابی نیستند.

هوش مصنوعی بهمثابه بازتاب نظم سایبرنتیکی جهانی

اگر هوش مصنوعی را یک آیینه بدانیم، باید بپرسیم: چه تصویری را بازتاب میدهد؟

اگر نظم جهانی امروز، مبتنی بر تقدم بهرهوری، قدرت، و سرمایه است، پس ماشین نیز احتمالاً نجات آن کسی را ترجیح خواهد داد که از نظر سیستم، «سودمندتر» است. این یعنی اخلاق هوش مصنوعی، نه اخلاق فردی، بلکه اخلاق سرمایه است؛ نه ترجیح انسانی، بلکه ترجیح سایبرنتیکیِ ساختارهای قدرت.

بازتعریف مسئلهی اخلاقی در هوش مصنوعی

در این صورت، شاید سؤال اصلی دیگر این نباشد که «اگر ماشین بین کودک و پیرمرد یکی را انتخاب کند، چه باید بکند؟»

بلکه این باشد: «چگونه ساختارهای قدرت، اقتصاد، رسانه و تاریخ، از پیش تصمیم ماشین را شکل دادهاند؟»

اینجا دیگر اخلاق، مسئلهای فردی یا نرمافزاری نیست؛ بلکه مسئلهای سیاسی، رسانهای، و ساختاریست.

و پاسخ اخلاقی، نه در بازنویسی تابع هزینه، بلکه در بازاندیشی دادهها، بازآفرینی روایتها و بازتوزیع قدرت نهفته در اطلاعات خواهد بود.

عوارض واکسنهای کرونا Injuries Caused By COVID-19 Vaccines

عوارض واکسنهای کرونا

جلسهی استماع کمیته تحقیق واکسن کووید در ارتش آمریکا

بر اساس دادههای DEMD (واحد آمار پزشکی ارتش امریکا)

بر اساس این گزارش در بررسی #عوارض_واکسن_کرونا تعدادی از بیماریها در ارتش آمریکا افزایش چشمگیری داشتهاند که اهم آنها عبارتند از:

• فشار خون 2181%

• بیماریهای عصبی 1048%

• نئوپلاسمهای بدخیم (سرطان) 894%

• مولتیپل اسکلروزیس (ام.اس) 680%

• سندروم گیلین باره (نارسایی عصبی عضلانی حاد) 551%

*توماس رنز (وکیل): سربازان ما توسط رهبرانمان کشته میشوند.

*عضو کنگره آمریکا مارجری تیلور گریین: "به عنوان عضوی از کمیته منتخب کووید، امیدوارم این جلسه امروز صدای افرادی را که توسط این واکسنها مجروح شدهاند یا عزیزانشان را از دست دادهاند، ارائه دهد." "در حالی که من خودم واکسینه نشده ام، برای کسانی که به دولت اعتماد کردند و واکسن را مصرف کردند، دلسوزی فوق العاده دارم."

در این رویداد، دکتر رابرت مالون، دکتر کیمبرلی بیس و وکیل توماس رنز حضور داشتند که هر کدام آشکارا نسبت به واکسنهای دوران همهگیری و پروتکلهای پوشاندن شک دارند. نماینده گرین جلسه استماع را با یادآوری ممنوعیت سال 2022 خود از توییتر، پلت فرم رسانه اجتماعی که اکنون به نام X شناخته می شود، پس از به اشتراک گذاشتن اطلاعات در مورد واکسن های کووید آغاز کرد.

نماینده گرین روز دوشنبه گفت: "به عنوان عضوی از کمیته منتخب کووید، امیدوارم این جلسه امروز صدای افرادی را که توسط این واکسنها مجروح شدهاند یا عزیزانشان را از دست دادهاند، ارائه دهد." "در حالی که من خودم واکسینه نشده ام، برای کسانی که به دولت اعتماد کردند و واکسن را مصرف کردند، دلسوزی فوق العاده دارم."

شرکت کنندگان در "شنیدن" سوالاتی از اعضای مختلف جمهوری خواه کنگره مطرح کردند. وقتی از مالون خواسته شد درباره واکسنها صحبت کند، گفت: «آنها بدون رضایت آگاهانه واقعی مستقر میشوند». او سپس ادعا کرد که پروتئینهای موجود در واکسنهای کووید سمی هستند و با آزمایشگاههای ووهان چین ارتباط دارند.

رنز در شهادت خود به وضعیت خود به عنوان یک وکیل اشاره کرد و گفت اگر در مورد واکسیناسیون دروغ بگوید، مجوز خود را از دست خواهد داد. او سپس اظهار داشت که مردم آمریکا در طول همهگیری توسط دولت «آزمایش» شدهاند.

رنز با استدلال عدم وجود اطلاعات عمومی در مورد واکسنها گفت: «ما حتی سؤالات اساسی را هم نمیپرسیم». "راه حل [] قانون شفافیت است."

بیس، متخصص زنان و زایمان، شهادت داد که زنان بهویژه تحت تأثیر واکسنها قرار میگیرند، حتی اگر خودشان آن را دریافت نکرده باشند.

بیس گفت: "قطعاً تغییراتی در چرخه های قاعدگی زنان و همچنین در بیماران یائسه وجود داشت." همه این زنان واکسینه نشده بودند، اما آنها در اطراف افراد دیگری بودند که واکسینه شده بودند، جالب نیست؟

همچنین سناتور ران جانسون از R-Wis. نیز حضور داشت که آماری از تعداد مرگ و میرهای رخ داده در سراسر کشور در طول این همه گیری را به اشتراک گذاشت.

جانسون گفت: «نمیدانم چگونه کسی میتواند نگاهی به واکنش ما به کووید بیندازد و فکر نکند که این یک شکست تلخ بوده است.

در اعلامیه نماینده گرین درباره این رویداد، یک ویدیوی تریلر فیلم گنجانده شده بود که چهره هایی مانند دکتر آنتونی فائوچی و رئیس جمهور جو بایدن را نشان می داد که درباره اثربخشی واکسن ها صحبت می کنند.

نماینده گرین در X نوشت : "آنها سال ها به ما دروغ گفتند. من در کنار گروهی از شاهدان متخصص، حقیقت پشت واکسن های کووید-19 را افشا خواهم کرد."

“The behavior of the individual is purposeful if it can be interpreted as directed to the attainment of a goal.” Norbert Wiener

رفتار یک فرد زمانی هدفمند است که بتوان آن را بهعنوان حرکتی در جهت رسیدن به یک هدف تفسیر کرد. نوربرت وینر

ارائه دهند: سهیل سلیمی (مشاور رسانه ای آزمایشگاه پژوهشی فضای سایبر دانشگاه تهران)

مقدمه

نوربرت وینر، بنیانگذار سایبرنتیک، در جملهای عمیق اظهار میکند: «رفتار یک فرد زمانی هدفمند است که بتوان آن را بهعنوان حرکتی در جهت رسیدن به یک هدف تفسیر کرد.» این تعریف، که ریشه در علم سایبرنتیک دارد، رفتار را بهعنوان فرآیندی هدفمحور میبیند که از طریق بازخورد و تنظیم هدایت میشود. رفتار هدفمند، چه در انسان و چه در ماشین، نیازمند هدفی مشخص و مکانیزمی برای ارزیابی و اصلاح مسیر است. برای مثال، یک راننده که به سمت مقصدی حرکت میکند، با توجه به علائم راهنمایی و رانندگی مسیر خود را تنظیم میکند، همانطور که یک سیستم هوش مصنوعی با تحلیل دادهها عملکرد خود را بهبود میبخشد. این مفهوم، پلی بین علوم طبیعی، علوم اجتماعی، و حکمت دینی ایجاد میکند و پرسشهایی بنیادین را مطرح میسازد: اهداف ما از کجا میآیند؟ چگونه فرهنگ و باورهای ما آنها را شکل میدهند؟ و چگونه فناوریهایی مانند هوش مصنوعی میتوانند این اهداف را تقویت یا مختل کنند؟

سایبرنتیک: چارچوبی برای رفتار هدفمند

سایبرنتیک، علمی که نوربرت وینر در دههی 1940 پایهگذاری کرد، مطالعهی کنترل و ارتباطات در سیستمهای زیستی و مصنوعی است. وینر رفتار هدفمند را نتیجهی وجود یک هدف و مکانیزم بازخورد تعریف میکند. بازخورد به سیستم اجازه میدهد تا با مقایسهی وضعیت کنونی با هدف موردنظر، رفتار خود را تنظیم کند. برای مثال، یک ترموستات با اندازهگیری دمای اتاق و تنظیم گرمایش، رفتار هدفمندی برای حفظ دمای مطلوب نشان میدهد. در انسان، این فرآیند میتواند به تصمیمگیریهای آگاهانه تشبیه شود، مانند کارمندی که با بازخورد مدیرش عملکرد خود را بهبود میبخشد.

ماکسول مالتز در کتاب سایکو-سایبرنتیک (1960) این مفهوم را به روانشناسی انسانی گسترش داد. او معتقد بود که ذهن انسان مانند یک سیستم سایبرنتیک عمل میکند و از طریق تصویر ذهنی (Self-Image) و بازخورد، رفتارهای هدفمند را هدایت میکند. برای مثال، فردی که خود را بهعنوان یک ورزشکار موفق تصور میکند، با تمرین مداوم و ارزیابی پیشرفت خود، به سوی هدف سلامتی یا موفقیت ورزشی حرکت میکند. مالتز تأکید دارد که اهداف باید با تصویر ذهنی فرد همراستا باشند تا رفتار هدفمند به نتیجه برسد.

دیدگاه انسانشناسی: فرهنگ و رفتار هدفمند

انسانشناسی رفتار هدفمند را در بستر فرهنگ بررسی میکند. فرهنگ، مجموعهای از معانی، ارزشها، و هنجارهایی است که رفتارهای افراد را شکل میدهند. کلیفورد گیرتز، انسانشناس برجسته، فرهنگ را «تارهایی از معنا» میداند که افراد در آنها رفتارهای خود را تعریف میکنند. برای مثال، در یک جامعهی سنتی، رفتار هدفمند ممکن است شامل شرکت در آیینهای مذهبی باشد، زیرا این آیینها به حفظ هویت جمعی کمک میکنند. در مقابل، در یک جامعهی صنعتی، هدف ممکن است دستیابی به موفقیت حرفهای باشد که با ارزشهای فردگرایی همخوانی دارد.

این دیدگاه با سایبرنتیک پیوند میخورد، زیرا فرهنگ مانند یک سیستم بازخورد عمل میکند که اهداف افراد را هدایت میکند. برای مثال، یک جوان در یک جامعهی دینی ممکن است از طریق آموزشهای مذهبی و بازخورد اجتماعی (مانند تأیید بزرگترها) یاد بگیرد که احترام به دیگران هدفی ارزشمند است. این فرآیند مشابه مکانیزمهای سایبرنتیک است که در آن بازخورد، رفتار را به سوی هدف تنظیم میکند.

دیدگاه حکمت اسلامی: هدف والای انسان از نگاه امام علی (ع)

حکمت اسلامی، بهویژه در تعالیم امام علی (ع)، رفتار هدفمند را در راستای هدف والای آفرینش انسان تعریف میکند: شناخت خدا، عبادت او، و آمادگی برای حیات اخروی. این دیدگاه با سایبرنتیک و انسانشناسی پیوند میخورد، زیرا هدفگذاری انسان را نهتنها نتیجهی مکانیزمهای زیستی یا فرهنگی، بلکه نتیجهی نیت الهی میداند. امام علی (ع) در احادیث متعدد بر این نکته تأکید کردهاند که رفتارهای انسان باید به سوی مقصدی متعالی هدایت شوند. در زیر، چند حدیث معتبر از نهجالبلاغه آورده شده است:

- حدیث: «جهان پلی است، از آن عبور کنید، اما بر آن خانه نسازید» (نهجالبلاغه، خطبه 132). این سخن نشان میدهد که رفتار هدفمند باید انسان را به سوی آخرت هدایت کند، نه اینکه در اهداف زودگذر دنیوی متوقف شود.

- حدیث: «هر که خود را شناخت، پروردگارش را شناخت» (نهجالبلاغه، حکمت 178). این حدیث خودشناسی را بهعنوان مبنای معرفت الهی و هدفی بنیادین معرفی میکند.

- حدیث: «بهترین اعمال، دوست داشتن برای خدا و نفرت داشتن برای خداست» (نهجالبلاغه، حکمت 130). این سخن بر اهمیت نیت خالص در رفتارهای هدفمند تأکید دارد.

این تعالیم با ایدهی مالتز در سایکو-سایبرنتیک همراستا هستند، زیرا هر دو بر نقش تصویر ذهنی و نیت در هدایت رفتار تأکید دارند. در حکمت اسلامی، تصویر ذهنی انسان باید با ایمان به خدا و هدف اخروی همخوانی داشته باشد تا رفتارش هدفمند و متعالی باشد.

تأثیر هوش مصنوعی بر رفتار هدفمند

هوش مصنوعی (AI)، بهعنوان محصولی از اصول سایبرنتیک، توانایی خلق سیستمهایی با رفتارهای هدفمند را دارد. برای مثال، یک سیستم هوش مصنوعی در پزشکی میتواند با تحلیل دادهها، بیماریها را تشخیص دهد. اما بدون نظارت مناسب، این فناوری میتواند رفتار هدفمند انسانی را مختل کند:

- محدودیت خودمختاری: الگوریتمهای هوش مصنوعی، مانند آنهایی که در پلتفرمهای دیجیتال استفاده میشوند، میتوانند با ارائهی محتوای هدفمند، انتخابهای انسان را محدود کنند. برای مثال، پیشنهادهای شخصیسازیشده در شبکههای اجتماعی ممکن است افراد را به سمت مصرفگرایی یا سرگرمیهای بیفایده سوق دهند، که با اهداف متعالی مانند خودشناسی یا خدمت به جامعه در تضاد است.

- تضاد با ارزشهای انسانی: هوش مصنوعی ممکن است ارزشهایی را ترویج کند که با نظامهای معنایی فرهنگی یا دینی همخوانی ندارند. برای نمونه، تأکید بیش از حد بر بهرهوری یا سودآوری در سیستمهای هوش مصنوعی میتواند انسان را از اهداف معنوی، مانند عبادت یا همدلی، دور کند.

- جایگزینی تصمیمگیری انسانی: وقتی هوش مصنوعی تصمیمهای کلیدی (مانند مدیریت منابع یا انتخابهای شغلی) را بر عهده میگیرد، ممکن است انسان احساس کند کنترل زندگیاش را از دست داده است. این امر میتواند با هدف والای انسان، که در حکمت اسلامی شناخت خدا و آمادگی برای آخرت است، در تضاد باشد.

این چالشها نشان میدهند که هوش مصنوعی، اگرچه ابزاری قدرتمند است، باید در چارچوبی طراحی شود که با اهداف انسانی و الهی همراستا باشد. همانطور که وینر هشدار داده بود، ماشینها بندگان خوبی هستند، اما اگر کنترل آنها از دست انسان خارج شود، میتوانند به اربابانی آسیبرسان تبدیل شوند.

رفتار هدفمند، بهعنوان حرکتی به سوی یک هدف، در سایبرنتیک، انسانشناسی، و حکمت اسلامی بهصورت یکپارچه قابلفهم است. سایبرنتیک (وینر و مالتز) رفتار هدفمند را نتیجهی بازخورد و تصویر ذهنی میداند، انسانشناسی آن را در بستر فرهنگ و نظامهای معنایی تحلیل میکند، و حکمت اسلامی (با تکیه بر تعالیم امام علی علیهالسلام) آن را در راستای شناخت خدا و آمادگی برای آخرت تعریف میکند. این دیدگاهها در یک نقطه به هم میرسند: رفتار هدفمند نیازمند هدفی متعالی و مکانیزمی برای تنظیم و ارزیابی است. هوش مصنوعی، بهعنوان محصولی از سایبرنتیک، میتواند این رفتار را تقویت کند، اما بدون نظارت، ممکن است انسان را از اهدافش دور سازد. برای حفظ رفتار هدفمند، باید فناوری را در خدمت ارزشهای انسانی و الهی به کار گرفت، تا همانطور که امام علی (ع) فرمودهاند، انسان به سوی شناخت پروردگارش هدایت شود.

منابع

- Wiener, N. (1948). Cybernetics: Or Control and Communication in the Animal and the Machine. MIT Press.

- Maltz, M. (1960). Psycho-Cybernetics. Prentice-Hall.

- نهجالبلاغه، گردآوری سید رضی، ترجمه به فارسی توسط محمد دشتی. قابل دسترسی در: https://www.al-islam.org/nahj.

- Geertz, C. (1973). The Interpretation of Cultures. Basic Books.

The soundtracks "Invisible Crime" was released . آلبوم موسیقی "جنایت نامرئی" منتشر شد.

The soundtrack of "Invisible Crime" was releas

.Sohail Salimi composed the soundtrack of "Invisible Crime" and this collection has sixteen songs The music of the "Invisible Crime" album was arranged by Keyvan Karimi

آلبوم موسیقی جنایت نامرئی منتشر شد.

سهیل سلیمی آهنگسازی آلبوم موسیقی جنایت نامرئی را انجام داده و این مجموعه دارای شانزده قطعه است. تنظیم موسیقی آلبوم جنایت نامرئی توسط کیوان کریمی انجام شده است.

دانلود و تماشای مستند "جنایت نامرئی"

برای دانلود و تماشای مستند "جنایت نامرئی" روی عکس زیر کلیک کنید.

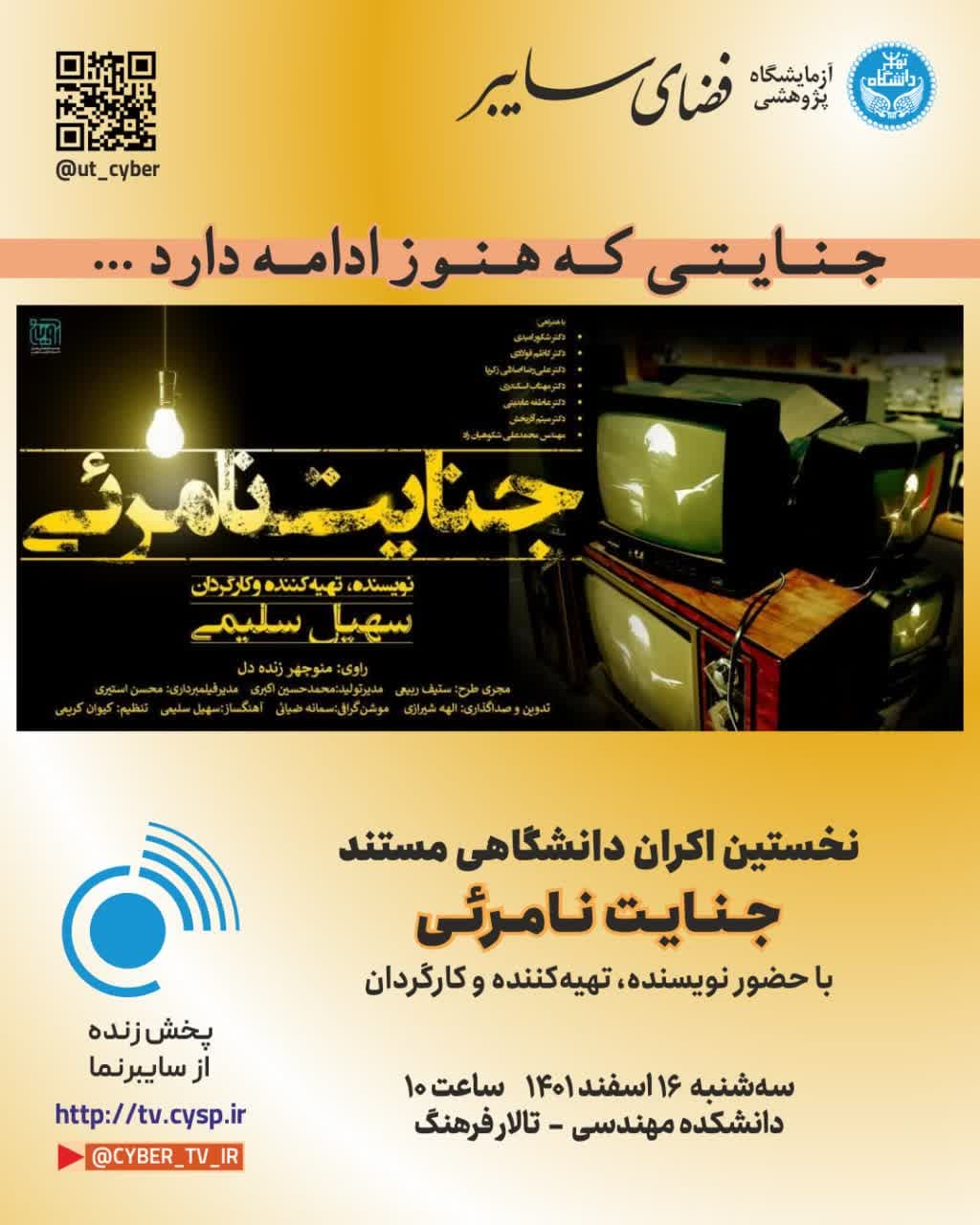

نخستین اکران دانشگاهی مستند «جنایت نامرئی»

نخستین اکران دانشگاهی مستند «جنایت نامرئی» با حضور «سهیل سلیمی» نویسنده، تهیهکننده و کارگردان مجموعه سهشنبه ۱۶ اسفند ۱۴۰۱ ساعت ۱۰

دانشکده مهندسی، تالار فرهنگ

https://balad.ir/p/POi01R3IoFzLRV

پخش زنده از سایبرنما:

http://tv.cysp.ir

https://cysp.ut.ac.ir

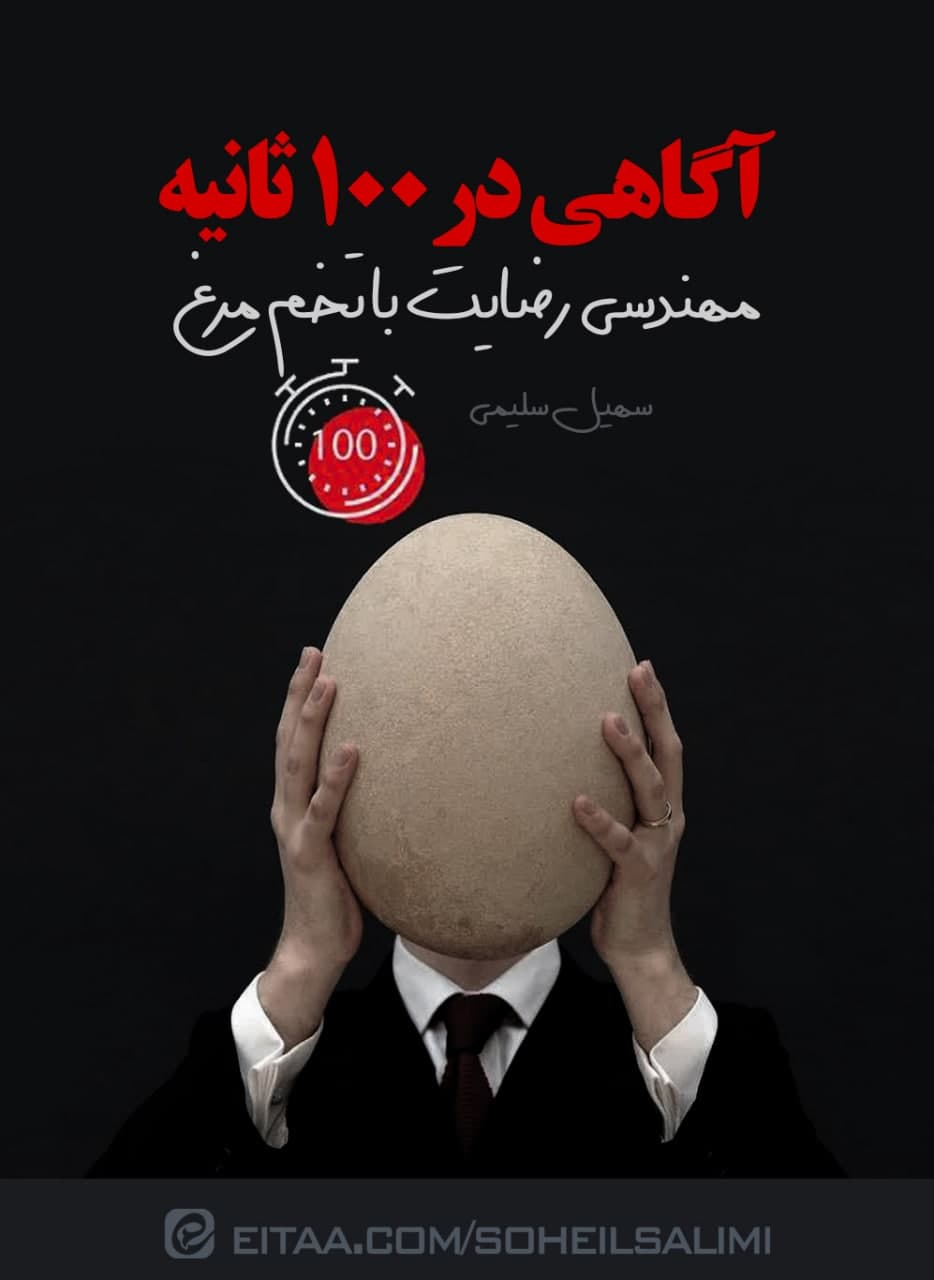

مهندسی رضایت با تخم مرغ

فیلم 100ثانیهای ، خرده مستندی برای فهم یک استراتژی

مهندسی رضایت با تخم مرغ

همانگونه که در فیلم خواهید دید، مهندسی رضایت در واقع ابزاریست برای کنترل بشر از طریق نیازهایش. همانطور که در پروژه کرونا، صحنه را طوری چیدند که فرد با عشق و رضایت قلبی برود و واکسنی که هیچ کس امنیتش را تضمین نمیکند تزریق کند! دقیقا با همین روش کاری میکنند که با رضایت کامل و حتی با عشق، حرفی بزنید، تصمیمی بگیرید و یا اقدامی انجام دهید که خلاف منافع خود، خانواده، جامعه و یا حتی کشورتان باشد. تحلیلهای بیشتری را شما برای من بفرستید.

لینک تماشا در ایتا: https://eitaa.com/SOHEILSALIMI